インターネットが普及し、情報が瞬時に手に入る現代において、Webスクレイピングの技術は広く利用されています。しかし、Webスクレイピングは有益な情報収集手段である一方で、自社サイトのデータを不正に取得されるリスクも伴います。

本記事では、Webスクレイピングから自社サイトに与える影響や、Webスクレイピングを防ぐ方法についてご紹介します。

Webスクレイピングとは

Webスクレイピングとは、インターネット上のウェブサイトから特定の情報を自動的に抽出する技術のことを指します。この技術は専用のプログラムやソフトウェアを使用して行われ、手動で情報を収集する手間や時間を大幅に削減することができます。

具体的には、スクレイピングツールがウェブサイトにアクセスし、そのページのHTMLコードを解析して必要なデータを取得します。例えば、オンラインショップの価格情報や、ニュースサイトの最新記事などが対象となります。このデータはその後、データベースに保存され、分析や利用が容易になります。

スクレイピングは、データ収集を効率化するために広く利用されていますが、一方で、無断で大量のデータを収集することはサイト運営者にとって迷惑行為となることもあります。そのため、スクレイピングを行う際には、対象サイトの利用規約を確認し、適切な方法で行うことが重要です。

スクレイピングの一般的な用途

Webスクレイピングは、インターネット上の膨大な情報を効率的に収集・解析するための技術です。この技術は、ビジネスや研究、マーケティングなど多岐にわたる分野で利用されており、ビジネスの効率化やデータドリブンな意思決定を支える重要な技術となっています。以下の表では、スクレイピングの具体的な用途をまとめます。

| 用途 | 説明 |

| 検索順位のモニタリング | 自社および競合サイトの検索順位を定期的に収集し、SEO対策の一環として活用します。 |

| 商品価格の比較 | 複数のECサイトから商品価格を収集し、価格比較サイトの運営や競合分析に利用されます。 |

| レビューの収集 | 各種商品のユーザーレビューを収集し、顧客満足度の分析や商品改善に役立てます。 |

| 株価の追跡 | 株式市場のデータをリアルタイムで収集し、投資判断の材料として利用します。 |

| 空室情報の収集 | 宿泊施設の空室情報を収集し、予約サイトの更新や空室状況の管理に利用されます。 |

| ニュース記事の収集 | 各種ニュースサイトから記事を収集し、トレンド分析や情報提供サイトのコンテンツとして利用します。 |

| ソーシャルメディアの分析 | X(Twitter)やFacebookなどの投稿を収集し、顧客の声やトレンドを分析するために使用されます。 |

スクレイピングによるウェブサイトへの影響

Webスクレイピングは、情報収集において強力な手段ですが、無制限に利用されるとウェブサイトに対してさまざまな悪影響を及ぼす可能性があります。以下に、その具体的な影響と対策について説明します。

データの不正利用

Webスクレイピングによる最大の問題は、収集されたデータが不正に利用されるリスクです。例えば、商品価格や顧客レビューなどのデータが競合他社に悪用されると、ビジネス戦略やマーケティング活動に大きな影響を与えます。

データの不正利用を防ぐためには、適切なアクセス制限やデータ暗号化の導入が必要です。

サーバー負荷の増大

無制限なスクレイピングは、ウェブサイトのサーバーに過剰な負荷をかけることがあります。特に、大量のリクエストが短期間に集中すると、サーバーの応答速度が低下し、ユーザーエクスペリエンスに悪影響を与えます。

このような事態を防ぐためには、リクエストの頻度を制限する仕組みや、サーバーのキャパシティを増強する対策が求められます。

SEOへの影響

Webスクレイピングは、検索エンジンのランキングにも悪影響を及ぼす可能性があります。大量のスクレイピングボットがサイトを訪れると、検索エンジンがそのサイトをスパムと認識することがあります。

これにより、検索順位が低下するリスクが生じます。SEO対策としては、ボットトラフィックを識別し、適切に対処することが重要です。

5つの主要なスクレイピング対策技術

Webスクレイピングから自社サイトを守るためには、さまざまな対策技術を駆使することが重要です。ここでは、代表的な5つのスクレイピング対策技術について詳しく説明します。

IPアドレス制限

IPアドレス制限は、Webスクレイピングを防ぐための基本的な手法の一つです。特定のIPアドレスから短期間に大量のリクエストが送信される場合、そのIPアドレスをブロックします。例えば、人間が通常行うアクセス速度を超えるリクエストが検出された場合、そのIPを一時的にまたは恒久的にブロックすることで、ボットの活動を制限します。

この対策は、スクレイピングを試みるボットが特定のIPから多数のリクエストを送信する行動を検出し、効率的にブロックするために役立ちます。

CAPTCHAの導入

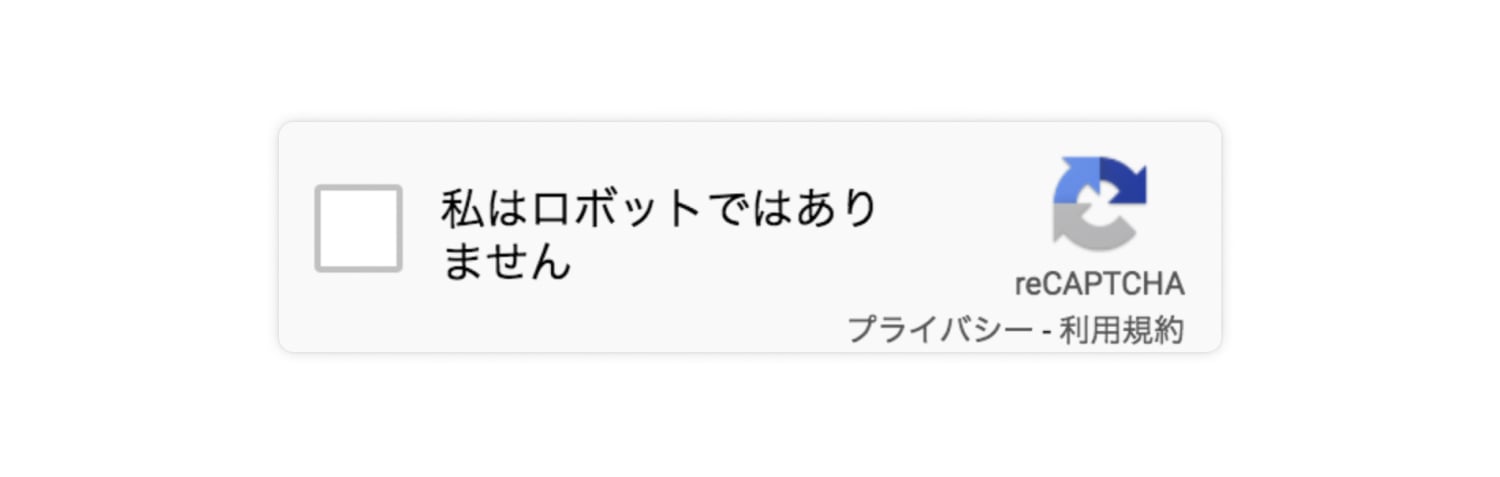

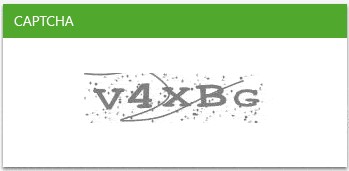

CAPTCHA(キャプチャー)とは、「Completely Automated Public Turing test to tell Computers and Humans Apart」の略で、人間かボットかを区別するためのテストです。例えば、画像から特定のオブジェクトを選択するよう要求するものや、歪んだ文字を入力させるものなどがあります。

これにより、ボットが自動的に情報を取得するのを防ぎます。CAPTCHAは、特に大量のリクエストを受けるWebサイトに対して有効であり、ボットのアクセスを困難にします。

<CAPTCHAの例>

1.チェックマークを入れる

2.特定の写真を選択する必要あり

3.正しい文字列を入力/選択する必要あり

認証システムの実装

認証システムの実装は、Webスクレイピングを防ぐための有効な方法です。特定の情報にアクセスする際に、ユーザーにログインを要求することで、正当なユーザーのみがアクセスできるようにします。

例えば、FacebookやTwitterなどのSNSアカウントを用いた認証システムを導入することで、信頼性の高いユーザーのみが情報にアクセスできるようにします。これにより、スクレイピングを試みるボットのアクセスを制限し、データの不正利用を防ぎます。

ユーザーエージェント検証

ユーザーエージェント検証は、Webスクレイピング対策として有効な手法です。ユーザーエージェントは、Webブラウザやデバイスの情報を含むHTTPヘッダーの一部であり、訪問者のアクセス方法を識別します。

例えば、異常なアクセスパターンやボットの特徴を持つリクエストを検出し、ブロックすることができます。これにより、不正なスクレイピング活動を識別し、対策を講じることが可能です。ユーザーエージェント検証を導入することで、正当なユーザーのみがアクセスできるようになり、セキュリティを強化します。

AJAXを活用したコンテンツ保護

AJAXを活用したコンテンツ保護は、スクレイピングを難しくするための効果的な手法です。AJAX(Asynchronous JavaScript and XML)は、ページ全体をリロードせずに部分的にデータを更新する技術です。これにより、ボットが特定のデータを取得するのが難しくなります。

例えば、ページの一部だけを動的に更新することで、スクレイピングツールが必要な情報を容易に取得できなくなります。AJAXを利用することで、セキュリティを強化し、スクレイピングからの保護を実現します。

スクレイピングから自社サイトを守るには?

Webスクレイピングによるリスクから自社サイトを守るためには、複数の防御策を組み合わせることが効果的です。ここでは、具体的な対策方法について詳しく説明します。

SNSアカウントによるログインを求める

SNSアカウントによるログインを求めることは、効果的なスクレイピング防止策の一つです。ユーザーにFacebookやTwitterなどのSNSアカウントでログインを要求することで、信頼性の高いユーザーのみがアクセスできるようになります。

この方法により、匿名性の高いボットからのアクセスを制限し、データの不正取得を防ぐことができます。また、ログイン後に提供する情報量を制限することで、より一層の防御が可能です。

IPトラッキングを活用する

IPトラッキングを利用することで、特定のIPアドレスからの不審なアクセスを検出し、ブロックすることができます。スクレイピングボットは特定のIPアドレスから大量のリクエストを送信することが多いため、これを監視することで早期に異常を発見し、対策を講じることが可能です。

IPアドレスのトラッキングは、サイトへの過度なアクセスを防ぐだけでなく、悪意あるユーザーの特定にも役立ちます。

CAPTCHAの活用

CAPTCHAを活用することで、ボットがサイトにアクセスするのを防ぐことが可能です。CAPTCHAは、簡単な画像認識やパズルを解く形式で導入されることが多く、これによりボットの活動を効果的に阻止します。

特に、大量のリクエストが発生するページに導入することで、スクレイピングのリスクを大幅に軽減することができます。

UA(ユーザーエージェント)の検証

ユーザーエージェント(UA)は、アクセスしているデバイスやブラウザの情報を提供します。これを利用して、通常のブラウザからのアクセスとボットからのアクセスを区別することが可能です。

UA情報を分析することで、異常なアクセスパターンや疑わしいリクエストを検出し、不正なスクレイピングを防ぐことができます。この方法は、特にスクレイピング対策として有効であり、サイトのセキュリティを向上させます。

WAF(Web Application Firewall)の導入

WAFを導入することで、スクレイピングボットの検出やアクセス制限が可能となり、サイトのセキュリティレベルを大幅に向上させることができます。

WAFは、Webアプリケーションに対する攻撃を防ぐためのセキュリティツールです。多彩な設定が可能であり、特定の脅威に合わせた防御策を提供します。スクレイピングからの防御策としても有効であり、サイトへの不正アクセスをブロックできます。

まとめ

Webスクレイピングは情報収集に便利な技術ですが、自社サイトにリスクをもたらすこともあります。これに対処するためには、適切な対策が必要です。本記事では、Webスクレイピングの基本からその影響、具体的な対策について説明しました。

スクレイピングはデータの不正利用やサーバー負荷増大、SEOへの悪影響を引き起こす可能性があります。これらのリスクを軽減するために、IPアドレス制限やCAPTCHAの導入、認証システムの実装、ユーザーエージェント検証、WAFの導入などの対策が有効です。

これらの対策を組み合わせて実施することで、スクレイピングによるリスクを大幅に軽減し、自社サイトのセキュリティを強化することが可能です。常に最新の対策を取り入れ、サイトを保護しましょう。