1. はじめに:社内データだけだと、会議が“感想戦”で終わる

私はID-POSで「売れた/落ちた」は追える一方で、「なぜ動いたのか」を社内データだけで説明しきれない場面に何度も直面してきました。競合の値下げ、EC上での露出増、レビューの悪化——それっぽい仮説は出るのに、裏取りがないと最後は感想戦で終わる。打ち手も検証も曖昧になります。

小売がECを本格導入するほど、意思決定に必要なのは「店内の結果」だけでなく、「店外(EC上)で何が起きたか」の定量情報だと痛感しました。そこで私は、Competitive Intelligence(競合の動きを外部データで捉える)という考え方も参考にしつつ、外部要因を“背景変数”として取りに行く方針に切り替えました。

この記事では、私が実際にやったことを「初めて読む方にも分かる順番」でまとめます。

結論を先に言うと

外部データ(競合価格・露出・レビュー)を定点で持つだけで、ID-POSの売上変動が「説明できる仮説」に変わります。施策を“勘”で打つのではなく、根拠を置いて優先順位を決められるようになります。私はまず1カテゴリ、1サイト、3指標から始めました。

この記事で分かること

- ID-POSに“外部データ”を足すと、売上変動の説明がどう変わるか

- ECでまず見るべき外部データ(価格・露出・レビュー)の取り方

- Octoparseを業務に組み込む際の最小ステップと運用の注意点

想定読者

- ID-POSは見ているが、原因説明や打ち手の根拠に悩んでいる方

- ECの競合状況を“数字で”把握したい小売・メーカーの担当者

- スクレイピングに興味はあるが、エンジニアリングは極力避けたい方

外部データ取得の手段として、私はノーコードでEC上の情報を定期収集できるOctoparseを試しました(ツール説明は最小限に留め、使いどころにフォーカスします)。

2. ID-POSとの活用イメージ:外部データ×ID-POSで“説明できる分析”に寄せる

2-1. まず集めた外部データは3つだけ(価格・露出・レビュー)

最初から何でも集めると運用が破綻するので、私はECに寄せて「購買に効きやすい3本」に絞りました。

- 競合の価格・SKU・在庫:値下げや品揃え変更のタイミングを定点観測する

- ECのランキング/キャンペーン露出:露出が増えた週と自社売上の変動を突き合わせる

- レビュー:件数・評価・内容の傾向を追い、変動の“納得できる理由”を補強する

検索量や天候も有効ですが、まずはEC上で直接観測できる指標を優先しました。取りに行きやすく、説明に直結しやすいからです。

2-2. なぜOctoparseを選んだのか(私の主観ベース)

同じ目的でも手段はいくつかあります。その中でOctoparseを使ってみて「業務に組み込みやすい」と感じた点は、主に次のとおりです。

| 手段 | 良い点 | つまずきやすい点 |

| 手作業(目視/Excel) | すぐ始められる | 継続・定点観測が難しい/再現性が低い |

| 自作(Python等) | 自由度が高い | 開発・保守の工数が重い/担当者依存になりやすい |

| Octoparse | ノーコードで定期収集しやすい | 対象サイト変更時に微調整が必要 |

今回は「まず運用を回して、効く指標を見極める」ことが目的だったので、スピードと継続性のバランスが良いOctoparseが合っていました。

- 自動検出(リスト認識)のおかげで、最短で“それっぽい形”まで到達できた

- テンプレート/カスタムの両方が使え、最初はテンプレで小さく試してから拡張できた

- クラウド実行で定期収集に回しやすく、日次・週次の運用が現実的になった

- 出力がCSV/Excelで扱いやすく、まずは手元の集計・検証にすぐ繋げられた

要するに、専門チームがいなくても「背景変数を持つ」ところまで持っていける感覚がありました。

特に助かったのは、収集対象のリスト構造を自動で捉えてくれる点と、定期実行に載せるまでの距離が短い点です。初回は手探りでも、2回目以降は「同じ型で回す」ことに集中できます。

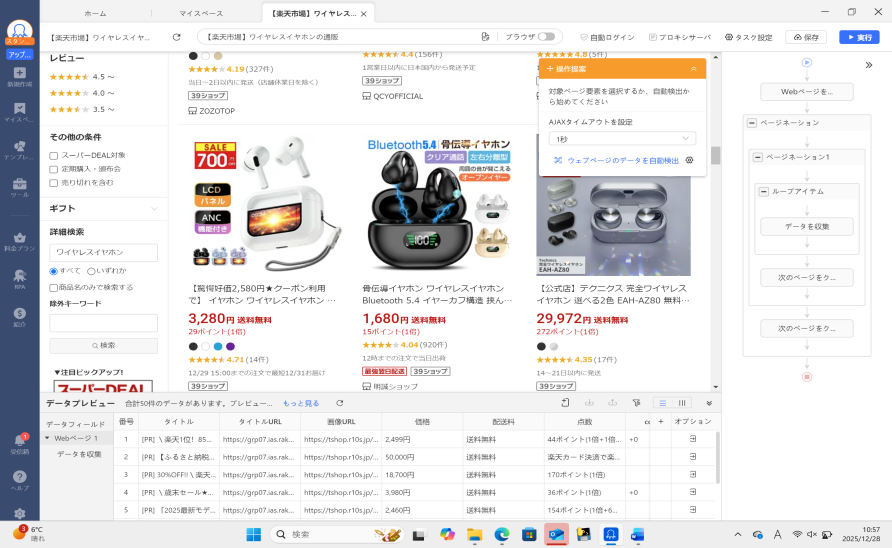

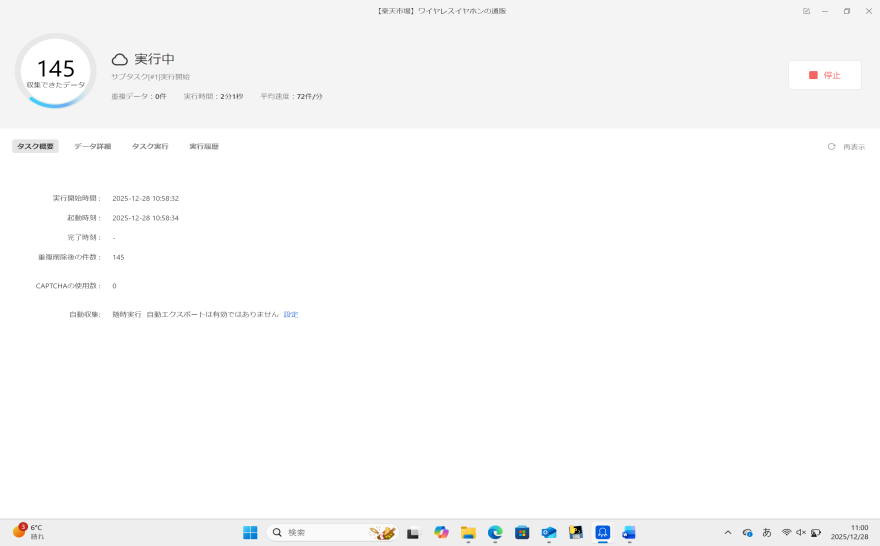

2-3. 実操作イメージ:テンプレート利用/カスタムタスク作成の最小ステップ

ここは読者が一番イメージしづらいところなので、私がやった流れを“最小構成”で書きます。実際は細かい調整もありますが、最初はこれで十分でした。

(補足)初回に詰まりやすいポイントは、だいたい次の3つです。

- 一覧ページと詳細ページのどちらから取るべきか迷う(まずは一覧で必要最小限を取るのが無難)

- 次ページ設定で取り漏れる(2〜3ページで必ずテストする)

- 取得結果が途中で0件になる(行数チェックの監視を入れる)

(A)テンプレートを使う場合(まずは試す)

1. テンプレート一覧から、目的に近いもの(例:ECの価格監視/商品情報収集)を選ぶ

2. 対象サイトのURLや条件を入れて、取得対象のページを指定する

3. 取得したい項目(商品名、価格、在庫表示、レビュー数など)だけを残す

4. 数ページだけ実行して、想定どおり取れているか確認する

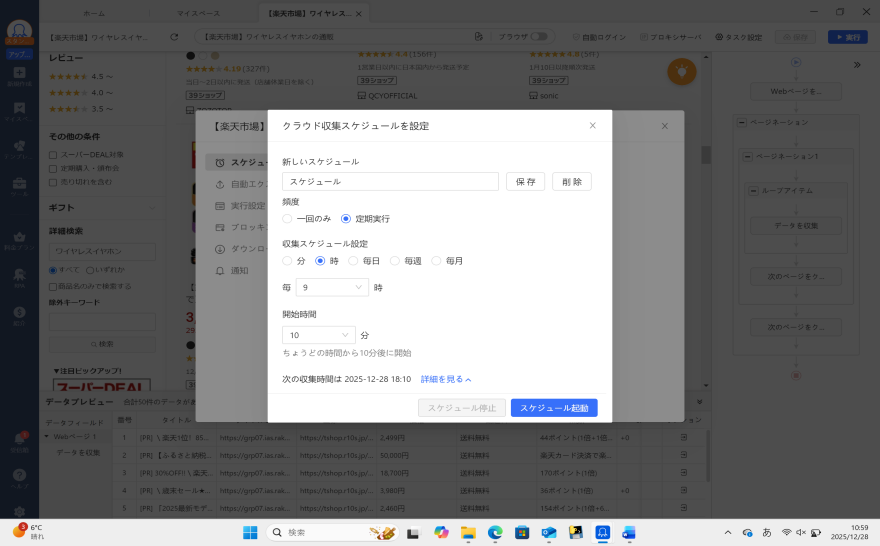

5. 問題なければクラウドで定期実行に回す(週次→日次の順で負荷を見ながら)

あわせて、取得したレビューや価格データをどのように商品選定に活かすかについては

👉 Amazonレビュー分析を商品選定に活用する方法 を参考にしつつ、

実運用前にはスクレイピング時の注意点や法的観点も

👉 Amazonスクレイピングにおける法的注意点 で必ず確認しておくと安心です。

(B)カスタムタスクで作る場合(対象が独自構造のとき)

1. 収集対象のURL(競合の商品一覧、ランキング、レビュー一覧など)をOctoparseに読み込ませる

2. 自動検出されたリストから「繰り返し部分(商品カード)」を確定する

3. 抽出項目(価格・商品名・在庫表示など)をクリックで選び、必要最小限にする

4. ページネーション(次ページ)を設定する

5. ローカルでテスト → クラウド定期実行へ移す

2-4. ID-POSにどう混ぜたか:まずは“週次の1枚ビュー”を作る

外部データは集めただけでは意味がありません。私は「粒度を揃える」「キーを揃える」「見る指標を絞る」の3点だけは崩さないようにしました。

キー突合は完璧を目指すより、現場で使う“代表SKU”に寄せる方が早いです。私は「JANで一致するものは素直に結合」「一致しないものは代表SKUに寄せた突合表で吸収」という2段構えにしました。

- 外部データを日次/週次に揃え、ID-POSと同じ時間軸で比較できるようにする

- JAN/自社商品コード/代表SKUで寄せ、ズレる部分は突合表で吸収する

- 見る指標は3つに固定(価格差×売上、露出×売上、レビュー×定着)

可視化としては、まず横軸を週にして、売上(またはPI値)と外部指標(価格差・ランキング・レビュー)を同じタイミングで並べました。相関を断定するのではなく、“同時に起きている現象”を見つけるだけで、次に見るべきデータや現場確認の優先度が決めやすくなります。

| 週 | 売上/PI | 価格差(自社-競合) | ランキング/露出 | レビュー(件数/評価) |

| W1 | — | — | — | — |

| W2 | — | — | — | — |

2-5. 私が詰まったケース:外部を置いたら、説明が一本通った

ある週、カテゴリ全体としては大きく崩れていないのに、自社の主力SKU群だけが目に見えて鈍化しました。ID-POSでは鈍化は確認できるものの、原因が棚・在庫・販促なのか、競合の動きなのか、EC上の露出なのかが切り分けられませんでした。

そこで競合のEC商品ページを定点で見たところ、その週に限ってポイント施策が強まり、実質価格差が広がっていました。加えてランキングでも競合SKUが上位に入り、レビュー件数も短期間で増えていました。社内データだけでは「なんとなく競合が強かった」で終わっていたものが、「価格差の拡大 × 露出増 × 評価の積み上がり」という説明 になりました。

重要なのは原因を断定することではなく、次の打ち手を“仮説に沿って”選べる状態にすることです。価格差が主ならポイント設計やセット販促、露出が主なら露出面の確保や商品ページ改善、レビューが主なら低評価理由の改善——議論が現実的になります。

こうした整理を可能にするのが、競合商品の価格、ポイント施策、ランキング、レビュー件数といったEC上の公開情報を定点で捉え、時系列で並べて見る視点です。

商品ページ情報や価格データを継続的に取得し、分析に活用する考え方は、

EC領域のデータ活用事例としてOctoparseの公式ユースケースでも整理されています。

また、マーケットプレイス上の外部データを意思決定に組み込んだ取り組みは、

eBayのカスタマーストーリーとして紹介されています。

3. 導入・運用のポイント:続く形にするための注意点

3-1. 法規・ルール面:「取れる」と「取ってよい」は別

スクレイピングは技術的に可能でも、運用としては「取ってよい範囲」を守ることが前提です。取得対象サイトの利用規約、robots.txtの方針、アクセス負荷(短時間に大量アクセスしない)には必ず配慮しました。組織で運用するなら、対象サイト/取得頻度/利用目的を明文化し、法務・コンプライアンス観点で先に確認しておく方が安全です。

3-2. 運用でハマりやすい点(実務の注意点)

実務でつまずきやすいのは「一度作って終わり」にならない点です。ECサイトはページ構造が変わりますし、表示の揺れもあります。私は次の点を運用ルールとして持つようにしました。

- 取得件数の急減・ゼロを検知するチェック(アラート)を入れる

- 取得項目は最小限から始め、効くと分かってから増やす

- 日次で見るもの/週次で足りるものを分ける

- まずは「1カテゴリ×1サイト」で検証し、効いた指標だけ横展開する

クラウドで定期実行にすると便利な反面、失敗しても気づかないリスクがあります。私は行数と更新日時だけは最低限チェックし、極端に少ないときはすぐ原因を見に行くようにしました。

また、責任分界(誰がジョブを見るか/失敗時に誰が直すか)を曖昧にすると続けるほど負債になります。私は“取得できているか”の監視だけは分析側で持ち、対象URLや項目の増減は目的が明確なときだけ実施するルールにしました。

3-3. まとめ:まずは「1カテゴリ×1サイト×3指標」から

Octoparseの価値は「スクレイピングができる」ことそのものではなく、ID-POSの変動に“説明力”を持たせられる点にあります。社内データだけだと議論が推測になりがちですが、外部の価格・露出・レビューという背景変数が入ると、仮説が現実味を帯びます。まずは小さく始め、効いたものだけを残して伸ばす。これが一番、現場で続きます。

競合サイト・EC・地図・SNS の情報を、Excel・CSV・Google Sheets にそのまま出力。

クリック操作だけで、価格・レビュー・店舗情報など必要な項目を自動抽出。

Google Maps・食べログ・Amazon・メルカリ向けテンプレートで、すぐに取得開始。

大量取得や定期実行でも止まりにくく、競合監視を継続できます。

毎日・毎週のデータ取得をクラウドで自動実行し、更新を見逃しません。

世界 600 万人以上が利用し、主要レビューサイトで高評価を獲得。