「データスクレイピングとは何?どんなメリットがある?」「データスクレイピングを活用する方法とは?」このような疑問をお持ちではありませんか? データスクレイピングとは、インターネット上の情報を効率的に収集するコンピューター技術のことです。SNSの情報収集、顧客リスト作成、競合分析など、あらゆるシーンで利用できます。

本コラムでは、データスクレイピングを知らない方のために、仕組みや活用シーンをわかりやすく解説します。また、初心者でもかんたんに使えるスクレイピングツールもご紹介しますので、ぜひ参考にしてください。

データスクレイピングとは?

データスクレイピングとは、インターネット上のWebサイトやデータベースから特定の情報だけを抽出する技術です。従来、人間が手動でやっていたコピー&ペースト作業を、ロボットが自動で行ってくれるため、リスト作成にかかる時間の大幅な短縮につながり、より専門性の高い業務に専念できます。

データスクレイピングは、民間企業や金融機関、行政にいたるまで、多くの団体・組織で活用されています。一般的にはプログラミングの知識が必要ですが、専用ツール(スクレイピングツール)を用いることで、初心者でも簡単にデータを取得が可能です。

クローリングとの違いは?

データスクレイピングと類似した概念に「クローリング」があります。両者は混同されがちですが、似て非なるものです。

- クローリング:Webサイト全体を巡回してあらゆる情報を収集する技術。そのため、不要な情報も含まれている

- スクレイピング:Webサイトやデータベースの中から特定の情報に絞って抽出する技術。どの情報を抽出するか事前に設定が必要。

このように、両者はどちらも情報を収集するという意味では同じですが、目的や収集対象となるデータに違いがあります。

ビジネスでデータスクレイピングが活用される理由とは?

データスクレイピングは近年ビジネスシーンでの活用が増えています。ここでは、データスクレイピングが活用される主な理由を解説します。

競合他社の情報収集のため

データスクレイピングを使うことで、競合他社のWebサイトやオンラインプラットフォームから情報収集を簡単に行うことができます。例えば、Amazonで出品しているECサイト事業者であれば、他社の出品価格や商品ラインナップをリアルタイムでモニタリングできます。

それにより、価格設定や新しい商品の出品に役立てることが可能です。その結果、市場内の競争力を保ち、売上アップにつながりやすくなります。

最新の市場動向を把握するため

データデータスクレイピングは、市場分析やトレンド分析にも有効な手法です。例えば、SNSで話題になっているトレンドワードを抽出したり、再生数が伸びているYouTube動画のサムネイル画像を分析することで、マーケティング戦略に活かすことが可能です。。

また、レビューサイトの口コミを収集し分析することで、消費者のリアルな声にもとづいた商品の企画や改善に活かすことができます。

大量のデータを迅速に取得するため

Webサイトからコピー&ペーストで情報を収集し、リストアップするのは膨大な時間と労力がかかりますが、データスクレイピングを活用すれば、自動的かつ高速に情報を取得できます。抽出したデータは、Excelやスプレッドシートにエクスポートできるため、転記の手間も掛かりません。

さらに、データ抽出のスケジュール設定をすれば、必要なデータをリアルタイムで取得することができるため、常に最新情報に保つことが可能です。

複数サイトのデータを集約し比較するため

複数のWebサイトからデータを集め、それらを一元的に管理したり、分析したりする際にもスクレイピングが利用されています。例えば、旅行比較サイトでは、航空券やホテルの価格情報を様々なWebサイトから取得し、一つのプラットフォーム上で比較できるようにしています。

データスクレイピングの仕組み

データスクレイピングとは、一体どのような仕組みなのでしょうか。ここではわかりやすく、3つのステップで解説します。

- ステップ1:リクエストの送信

まず、指定されたWebサイトに対して「HTTPリクエスト(GETリクエスト)」を送信します。これは、ユーザーがブラウザでWebページを開く動作と同じ仕組みで行われます。

- ステップ2:HTMLの解析

Webページが返答すると、HTMLデータを受け取り、自動的に情報収集を開始します。特定のタグやクラス、IDを指定することで、欲しいデータのみ抽出することが可能です。

- ステップ3:データの取得と保存

抽出したデータは、CSVやExcel、データベースなどの形式に保存されます。これにより、後から分析や活用がしやすくなります。

データスクレイピングの活用シーン

データスクレイピングは、さまざまな業界や団体で活用されています。例えば、市場調査や競合分析、トレンド分析など、多岐にわたる用途があり、企業の意思決定をサポートしています。ここでは、データスクレイピングの主な活用シーンをご紹介します。

消費者のトレンド分析

SNSやニュースサイトをスクレイピングすることで、どういったものが流行っていたり、注目されていたりするかを分析できます。企業がデータスクレイピングを活用することで、消費者の関心に合わせた商品開発やマーケティング施策を実施することが可能です。

求人情報の収集と分析

複数の求人サイトから情報を収集し、職種ごとの給与相場や募集状況を分析する際にスクレイピングが活用されています。それにより、特定の地域や職種の平均賃金を調べたり、求人サイトごとに掲載件数を調べたりすることも可能です。

投資・金融データの収集

株価や経済指標、企業の業績データなどをスクレイピングし、リアルタイムで分析することで、迅速な投資判断に役立てることが可能です。例えば、金融機関や投資家は、ニュースサイトや企業の財務報告書からデータを収集することで、市場の変動を素早くキャッチしています。

研究・学術分野でのデータ収集

論文データベースや政府の統計データを収集し、分析する際にもデータスクレイピングが活用されます。例えば、研究者であれば手作業では困難な大規模データの取得が可能になり、より精度の高い研究に時間を費やせるようになります。

おすすめのデータスクレイピングツール5選

一般的に、データスクレイピングを行うには、プログラミングスキルが求められます。したがって初心者がデータスクレイピングを行うにはハードルが高いと感じる方も多いでしょう。

そのような時におすすめなのが、データスクレイピングツールの活用です。多くのツールが、プログラミング操作を必要としない、ノーコードツールとなっています。ここでは、人気のスクレイピングツールを5つ紹介します。

Octoparse

Octoparse は、コーディング不要で誰でも簡単にWebスクレイピングを行えるツールです。ドラッグ&ドロップのインターフェースを採用しており、直感的な操作が可能です。

特徴

- ノーコードで簡単に使える:初心者でも設定が簡単で、プログラミング不要。

- クラウド対応:24時間365日自動でデータを取得し続けることが可能。

- スクレイピングテンプレートが豊富:Google検索、Amazon、食べログなどのテンプレートを利用できる。

Bright Data

Bright Dataは、プロキシネットワークと強力なスクレイピング機能を備えた、業界トップクラスのWebデータプラットフォームです。世界中の公開データを取得できるため、大規模なデータ収集に適しています。

特徴

- 高性能なプロキシネットワーク:195ヵ国に対応し、IPブロックやCAPTCHAの回避が可能。

- カスタマイズ可能なスクレイパー:特定のWebサイト向けに最適化されたAPIを提供。

- 大規模データセットの活用:Eコマース、金融、広告などの分野で利用可能なデータを提供。

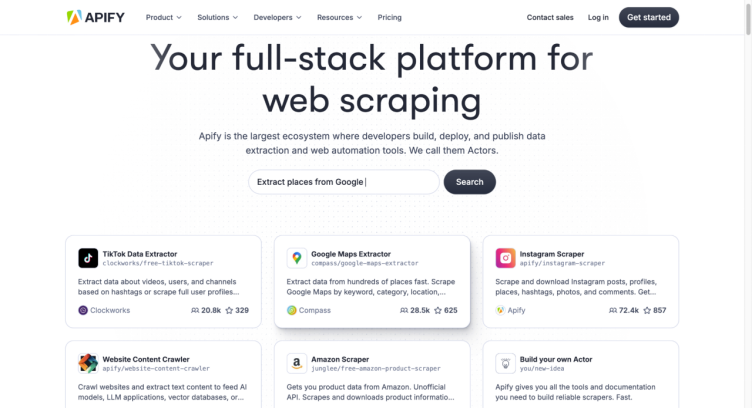

Apify

Apifyは、Webスクレイピングやブラウザ自動化を行うためのフルスタックプラットフォームです。開発者向けのツールが豊富で、既存のスクレイピングスクリプトを利用したり、独自のカスタムスクレイパーを作成したりできます。

特徴

- 3,000以上のスクレイピングツールを提供:Google MapsやInstagramなど主要サイト向けのテンプレートあり。

- 開発者向けの柔軟なカスタマイズ:PythonやJavaScriptでスクレイパーを構築可能。

- クラウドでの自動実行:サーバーレス環境でスクレイピングタスクを管理できる。

Web Scraper

Web Scraperは、Chromeの拡張機能として利用できるWebスクレイピングツールです。コーディング不要で、視覚的なインターフェースを使って簡単にスクレイピングを設定できるため、初心者にもおすすめです。

特徴

- ノーコードで利用可能:Chrome拡張機能を使って、クリック操作でスクレイピングを設定。

- クラウド版で自動実行:定期的なデータ取得やAPI連携が可能。

- 多様なデータ出力形式:CSV、XLSX、JSONなどのフォーマットに対応。

Browse AI

Browse AIは、ノーコードでWebデータのスクレイピングやページの変化を監視できるツールです。特に、事前にトレーニング済みのロボットを活用することで、素早くスクレイピングを開始できる点が特徴です。

特徴

- ノーコードでスクレイピング可能:クリック操作のみでデータ抽出やサイトの監視を設定できる。

- 自動データ監視機能:Webページの変更を検出し、スケジュール設定や通知が可能。

- 豊富なプリセットロボット:Eコマース、求人、不動産など200種類以上のテンプレートを提供。

データを保護する4つの方法

データスクレイピングは、正しく活用すればビジネスの強力な武器となりますが、不正なスクレイピングによる情報漏洩やセキュリティリスクも懸念されます。企業や個人が自社のデータを守るために、以下の4つの対策を講じることが重要です。

リクエストの制限を設ける

Webサイトに対するアクセス頻度を制限することで、不正なスクレイピングを防ぐことができます。例えば、一定時間内に特定のIPアドレスからのアクセス回数を制限する「レートリミット」を設定することで、異常な頻度でデータを取得しようとするボットをブロックできます。

また、異常検知システムを導入することで、短時間に大量のリクエストが発生した場合に自動的にアクセスを遮断することも可能です。さらに、ログインが必要なページに二段階認証を導入すれば、正規のユーザーのみがデータにアクセスできるようになり、不正なスクレイピングのリスクを大幅に低減できます。

CAPTCHAを活用する

スクレイピングボットは自動化されたプログラムであるため、人間の操作を必要とする認証システムを導入することで、不正アクセスを防ぐことができます。例えば、GoogleのreCAPTCHAを活用すれば、疑わしいアクセスに対して画像認証やチェックボックスを求めることができ、ボットによるデータ収集を防ぐことが可能です。

また、マウスの動きやスクロールの仕方を分析する行動解析型CAPTCHAを導入することで、より高度な防御策を講じることができます。さらに、通常のユーザー体験を損なわないよう、特定の条件下でのみCAPTCHAを表示する動的CAPTCHAを活用すれば、セキュリティと利便性のバランスを取ることができます。

重要な情報を画像化する

スクレイピングツールは主にテキストデータを解析するため、価格情報や連絡先などの重要なデータを画像として表示することで、不正なスクレイピングを困難にすることができます。例えば、企業の連絡先情報を画像として埋め込むことで、ボットによる情報取得を防ぐことが可能です。

さらに、アクセスごとに異なる画像URLを生成する動的な画像生成を活用すれば、スクレイピングツールが情報を取得するのをより一層難しくできます。また、画像に付与されるalt属性に過剰なテキスト情報を含めないようにすることで、スクレイピングによるデータ取得をより困難にすることができます。

データの構造を頻繁に変更する

スクレイピングツールは、WebサイトのHTML構造を解析し、特定のタグやクラス名をもとにデータを取得します。そのため、定期的にサイトのレイアウトやコードの構造を変更することで、スクレイピングの難易度を上げることが可能です。

例えば、HTMLのクラス名やIDを定期的に変更することで、スクレイパーが特定のデータを識別しにくくなります。また、ダミーデータを挿入することで、スクレイピングされた情報の正確性を低下させることも有効な手段です。

さらに、アクセス制限を設けたAPI経由でデータを提供するようにすれば、適切な認証を受けたユーザーのみが情報にアクセスできるようになり、不正なデータ取得を効果的に防ぐことができます。

まとめ

データスクレイピングは、競合分析や市場調査などに活用される便利な技術ですが、不適切な運用は法的リスクやセキュリティ上の問題を引き起こす可能性があります。本記事では、スクレイピングの仕組みや活用シーン、おすすめツール、そしてデータ保護の方法について解説しました。

スクレイピングを行う際は、Webサイトの利用規約や法的ルールを遵守し、適切なツールを選ぶことが重要です。また、不正なスクレイピングを防ぐためには、リクエスト制限やCAPTCHAの導入、データの画像化などの対策を講じる必要があります。

適切なスクレイピングの活用は、ビジネスの効率化や競争力の強化につながります。倫理的な運用を心がけながら、目的に応じた最適な手法を取り入れていきましょう。

競合サイト・EC・地図・SNS の情報を、Excel・CSV・Google Sheets にそのまま出力。

クリック操作だけで、価格・レビュー・店舗情報など必要な項目を自動抽出。

Google Maps・食べログ・Amazon・メルカリ向けテンプレートで、すぐに取得開始。

大量取得や定期実行でも止まりにくく、競合監視を継続できます。

毎日・毎週のデータ取得をクラウドで自動実行し、更新を見逃しません。

世界 600 万人以上が利用し、主要レビューサイトで高評価を獲得。