Webサイトから大量のデータを迅速に取得する必要がある場合、各Webサイトに手動でアクセスしてデータをコピペするのは現実的ではありません。そこで役立つのが「Webスクレイピング」です。Webスクレイピングを活用することで、このプロセスを自動化できます。

本記事では、Pythonを使用してWebサイトからデータを収集し、CSVファイルに書き込むWebクローラーを作成する方法を紹介します。

必要なPython開発環境

PythonでWebクローラーを作成するためには、適切な開発環境を整えることが重要です。以下に必要な環境とツールについて詳しく説明します。

Pythonのインストール

まず、Pythonのインストールが必要です。Pythonの公式サイトから、Python 3.xの最新バージョンをダウンロードしてインストールしてください。

ライブラリのインストール

Webクローラーを開発するには、いくつかのライブラリをインストールする必要があります。これらのライブラリは、ブラウザの操作、HTML解析、データの保存などの機能を提供します。

Selenium

ブラウザを自動的に操作するためのライブラリです。主にWebアプリケーションのテストやWebスクレイピングに利用されます。

インストールコマンド:

| pip install selenium |

BeautifulSoup

HTMLおよびXMLドキュメントを解析するためのライブラリです。Webページから必要な情報を抽出するのに便利です。

インストールコマンド:

| pip install beautifulsoup4 |

csv

CSVフォーマットでデータを保存するための標準ライブラリです。データをCSVファイルに出力する際に使用します。

ブラウザの準備

ライブラリを利用するためには、Webブラウザが必要です。

ここではGoogle Chromeを使用しますが、他のブラウザ(Firefox、Edgeなど)でも同様に設定できます。

Google Chrome:最新バージョンのChromeブラウザをインストールします。

Webドライバーのインストール

Webブラウザを操作するためには、対応するWebドライバーが必要です。ここではChromeDriverを例に説明します。

ChromeDriver

Chromeブラウザを操作するためのWebドライバーです。以下の手順でインストールします。

- ChromeDriverの公式サイトから、使用しているChromeのバージョンに対応するドライバーをダウンロードします。

- ダウンロードしたファイルを解凍し、実行可能なファイル(chromedriver.exe)を任意のフォルダに配置します。

WebDriver Manager

Webドライバーのインストールと管理を簡単にするために、WebDriver Managerを使用する方法もあります。

インストールコマンド

| pip install webdriver-manager |

使用例

| from selenium import webdriver from webdriver_manager.chrome import ChromeDriverManager driver = webdriver.Chrome(ChromeDriverManager().install()) |

これらの準備が整ったら、実際にPythonコードを書いてWebクローラーを作成することができます。ブラウザの操作やデータの抽出がスムーズに行えるように、必要なライブラリやツールを適切にインストールしておくことが重要です。

Seleniumとは

Seleniumは、ブラウザを自動的に操作するためのライブラリです。主にWebサイトやWebアプリケーションのテストやWebスクレイピングに利用されます。以下にSeleniumの主な特徴と利用方法を示します。

Seleniumの主な特徴

- ブラウザ操作の自動化:SeleniumはChromeやEdgeなどのブラウザを自動的に操作できます。これにより、手動操作をプログラムによって自動化し、繰り返し作業や大量のデータ取得を効率化できます。

- 動的ページの対応:Seleniumは静的ページだけでなく、JavaScriptで動的に生成されるページにも対応できます。そのため、ログイン機能やインタラクティブな要素を持つWebページも操作可能です。

Seleniumの基本的な使い方

1.インストール

Seleniumを使用するには、まずPython環境にインストールする必要があります。

| pip install selenium |

2.WebDriverの設定

WebDriverを使ってブラウザを操作するための設定を行います。以下はChromeDriverを使用する例です。

Selenium 3の場合

| from selenium import webdriver options = webdriver.ChromeOptions() driver = webdriver.Chrome(executable_path=”./path/to/chromedriver”, options=options) |

Selenium 4の場合

| from selenium import webdriver from selenium.webdriver.chrome.service import Service options = webdriver.ChromeOptions() service = Service(executable_path=”./path/to/chromedriver”) driver = webdriver.Chrome(service=service, options=options) |

3.基本操作

Seleniumを使ってブラウザを開き、指定したURLにアクセスし、要素を操作します。

| from selenium import webdriver from webdriver_manager.chrome import ChromeDriverManager driver = webdriver.Chrome(ChromeDriverManager().install()) driver.get(“https://www.python.org”) # 要素の取得と操作 search_box = driver.find_element_by_name(“q”) search_box.send_keys(“Selenium”) search_box.submit() |

Seleniumを利用することで、手動操作の手間を省き、効率的にWebサイトの操作やデータ収集を行うことができます。Webスクレイピングの他、Webアプリケーションのテスト自動化にも広く利用されています。

Webスクレイピングの実施例(Googleの検索結果から)

1.テキストエディタを起動し、下記のサンプルコードを記入したら、ファイルを“.py”という拡張子で保存します。

2.コマンドプロンプトを起動し、先程保存したファイルのあるディレクトリへ移動します。

3.コマンドプロンプトに”python ◯◯.py”と入力し、実行すれば操作完了です。◯◯の部分は保存したファイル名を入力しましょう。

[サンプルコード:テキスト情報の取得]

| from selenium import webdriver driver = webdriver.Chrome(‘chromedriverの保存先のパスを入力します’) url = https://www.google.com/ #アクセスしたいWebページのurlを入力 driver.get(url) elm = driver.find_element_by_class_name(‘MV3Tnb’) print(elm.text) |

Octoparseでスクレイピングする方法

プログラミングが苦手、あるいは英語のコードばかりなので苦手意識を持っている方は、スクレイピングツールのOctoparseをおすすめします。

Octoparseは「自動識別」機能があるので、ページのURLを入力するだけで、Webページ上各項目のデータ(テキストとリンクを含む)、「次のページ」ボタン、「もっと見る」ボタン、およびページのスクロールダウンを自動的に検出し、タスク(Webクローラー)を自動的に生成することができます。

早速ですが、Octoparseで自動化の魅力を体験してみましょう。

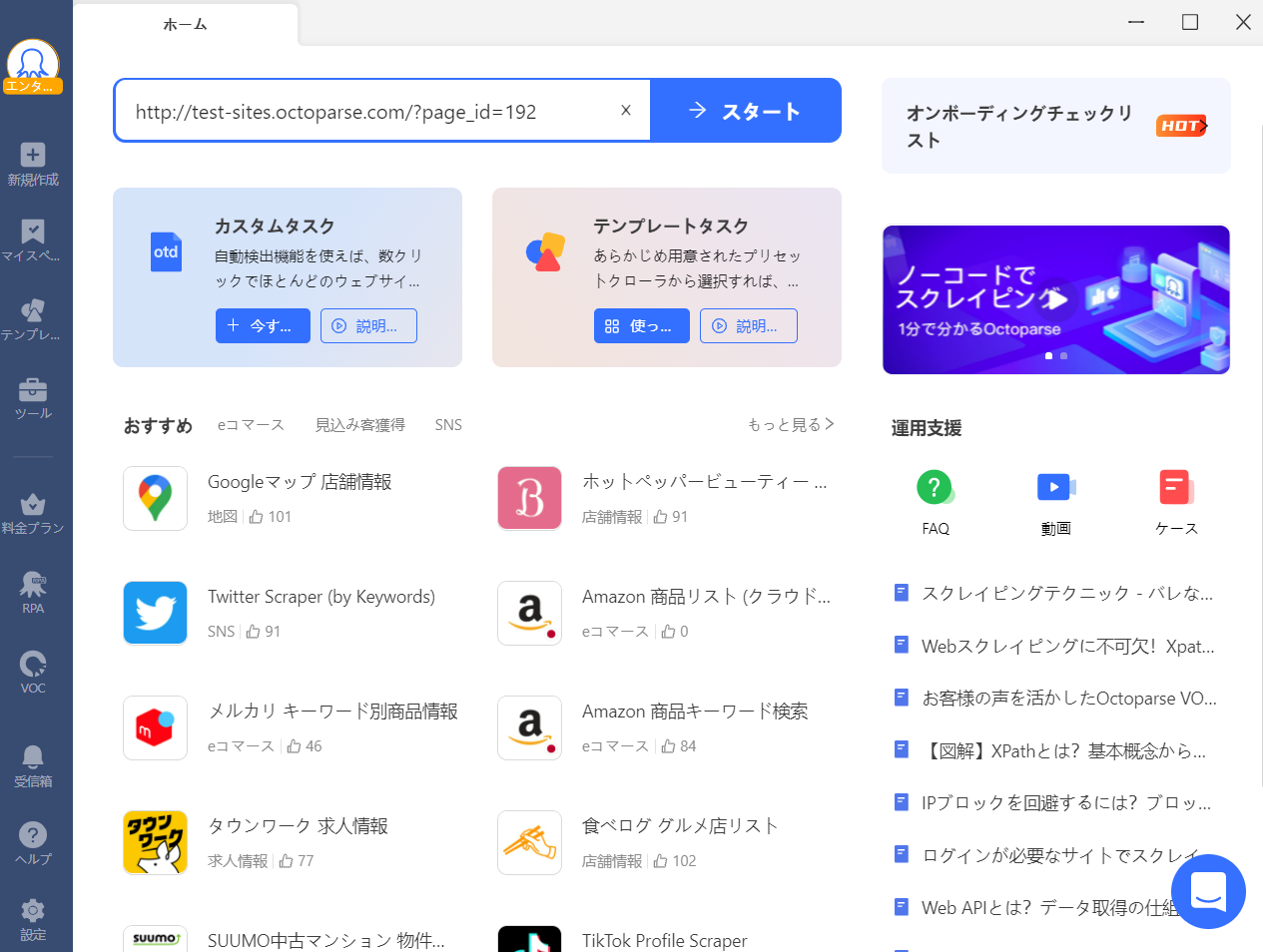

1. Octoparseを起動して、スクレイピングしたいWebページのURLを入力します。

「スタート」 ボタンをクリックして進みます。

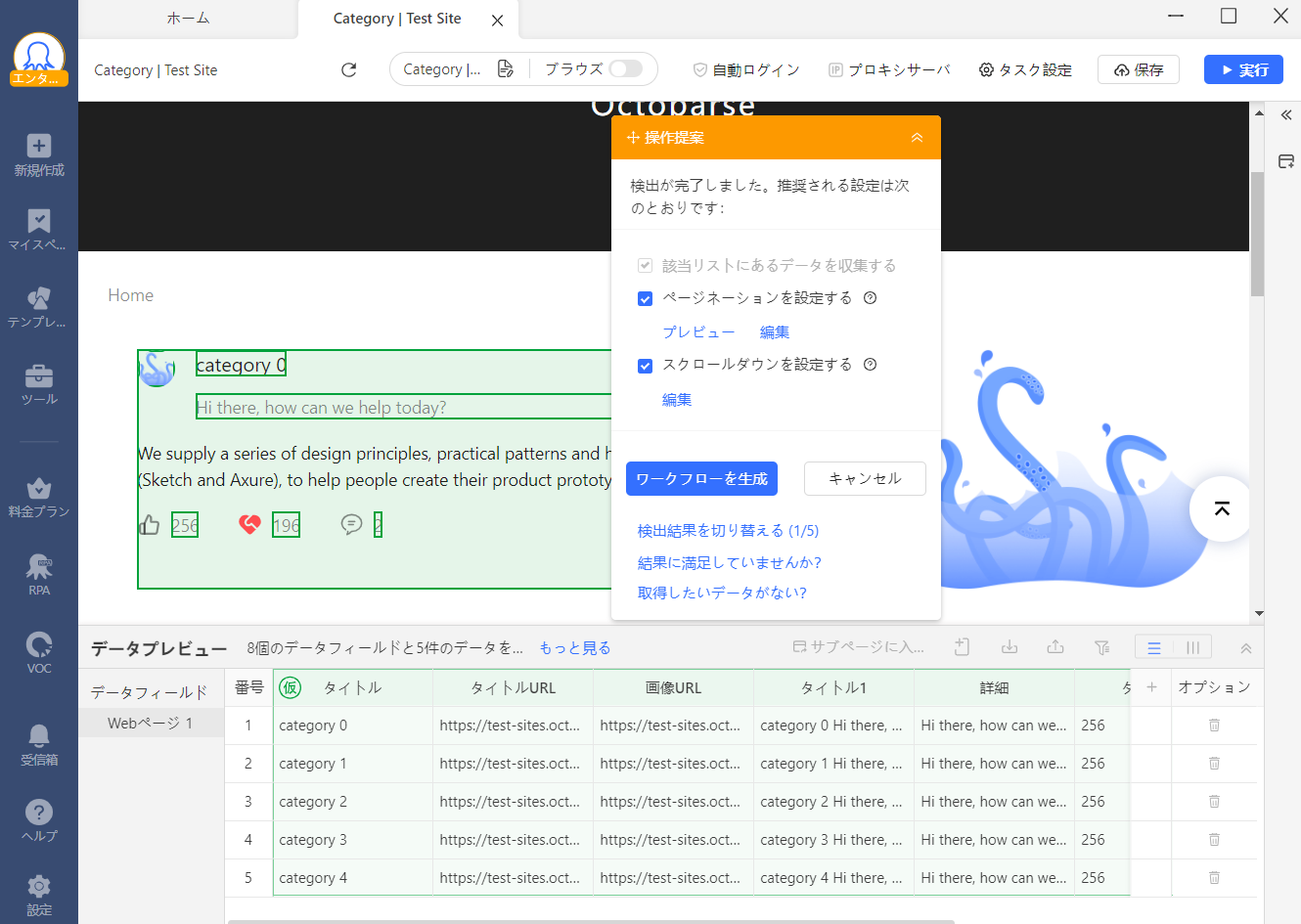

2. Octoparseでページが読み込まれたら、自動的にページ上の内容を識別します。

自動識別とは、自動的にページ上の必要なデータを検出して識別するという役立つ機能です。ポイント&クリックをする必要はなく、Octoparseは自動的に処理します。

3. 識別が完了すると、データプレビューで識別したデータを表示され、確認してから「ワークフローを生成」ボタンを押します。

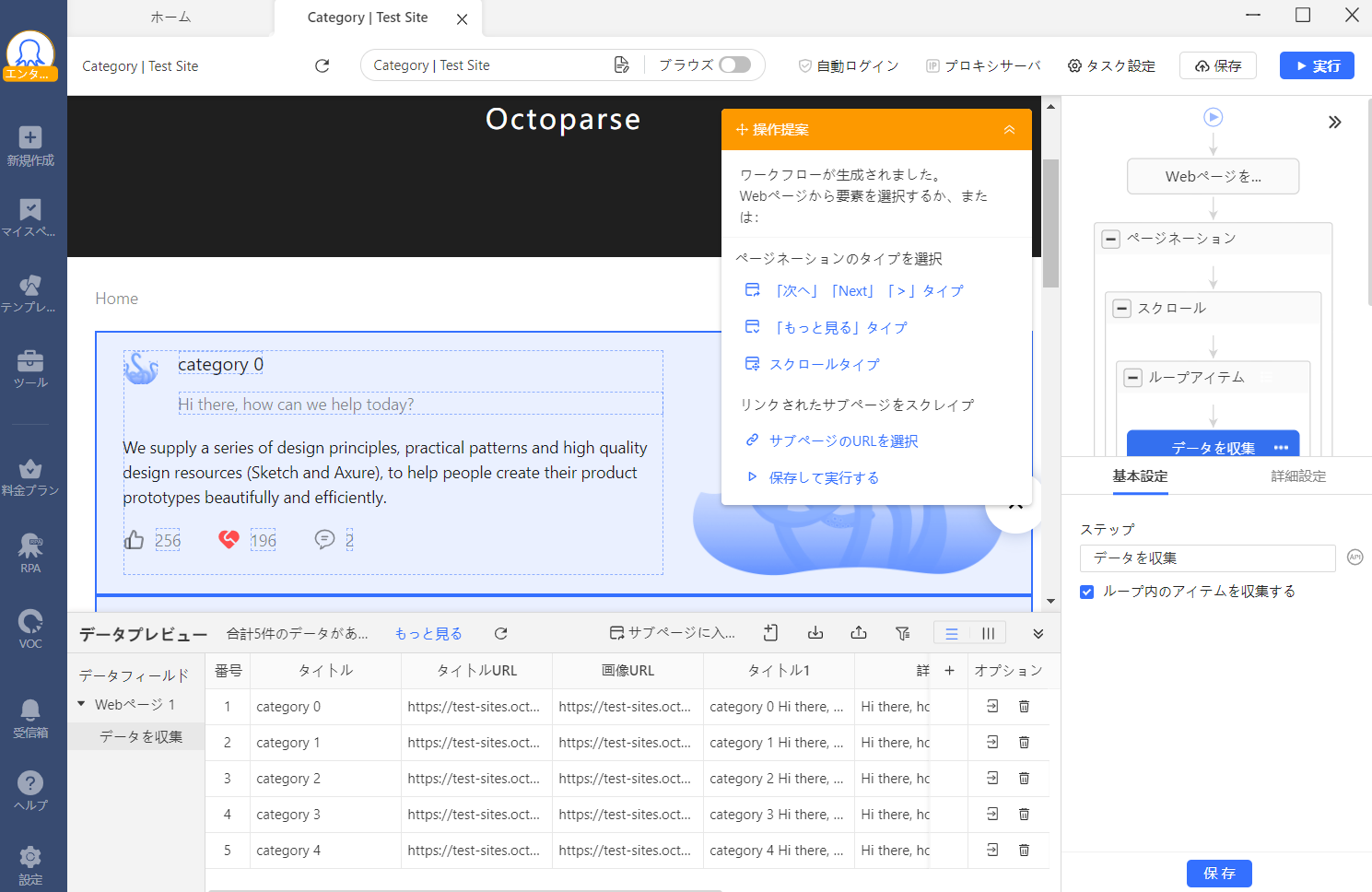

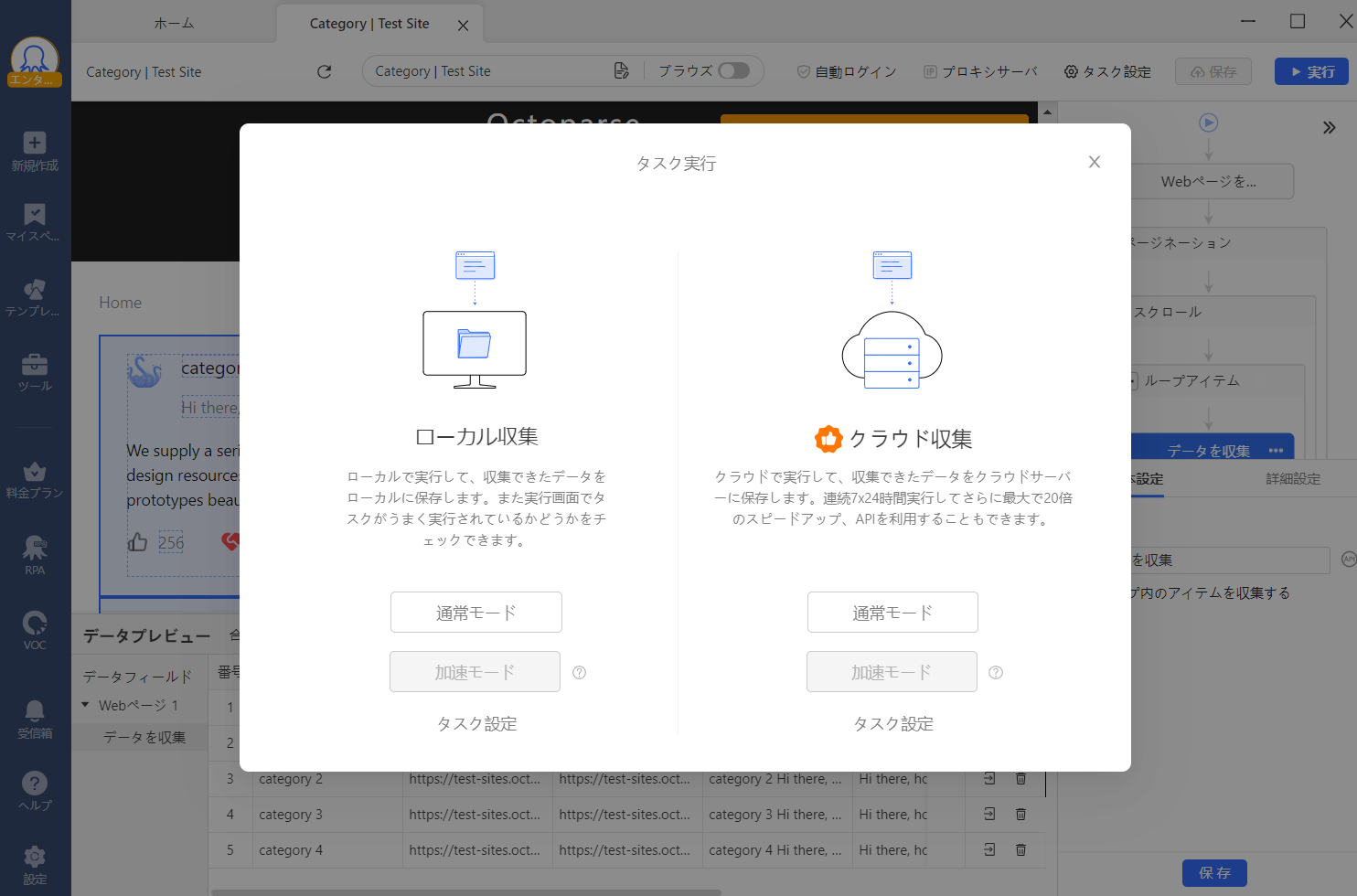

4. これでWebクローラーが完成しました!

完成後は「実行」ボタンをクリックすると、すぐにデータ抽出が可能です。とても簡単ですね!

スクレイピングテンプレートの使い方

Octoparseを使えば、Pythonなどのプログラミングをしなくとも、簡単にスクレイピングが可能です。しかし、中には「ワークフローを作成するのが面倒」「ワークフローを作ってみたけど欲しいデータが上手く抽出されない」といった方もいるかと思います。

Octoparseでは、ワークフローをテンプレート化した「クローラーテンプレート」を用意しています。クローラーテンプレートを使えば、多くの人々が普段よく利用する人気サイトから、わずかな操作だけで、データ収集が可能です。https://www.octoparse.jp/template/google-search-scraper

1.事前準備:Octoparseをダウンロードし、お使いのOSにインストールします。

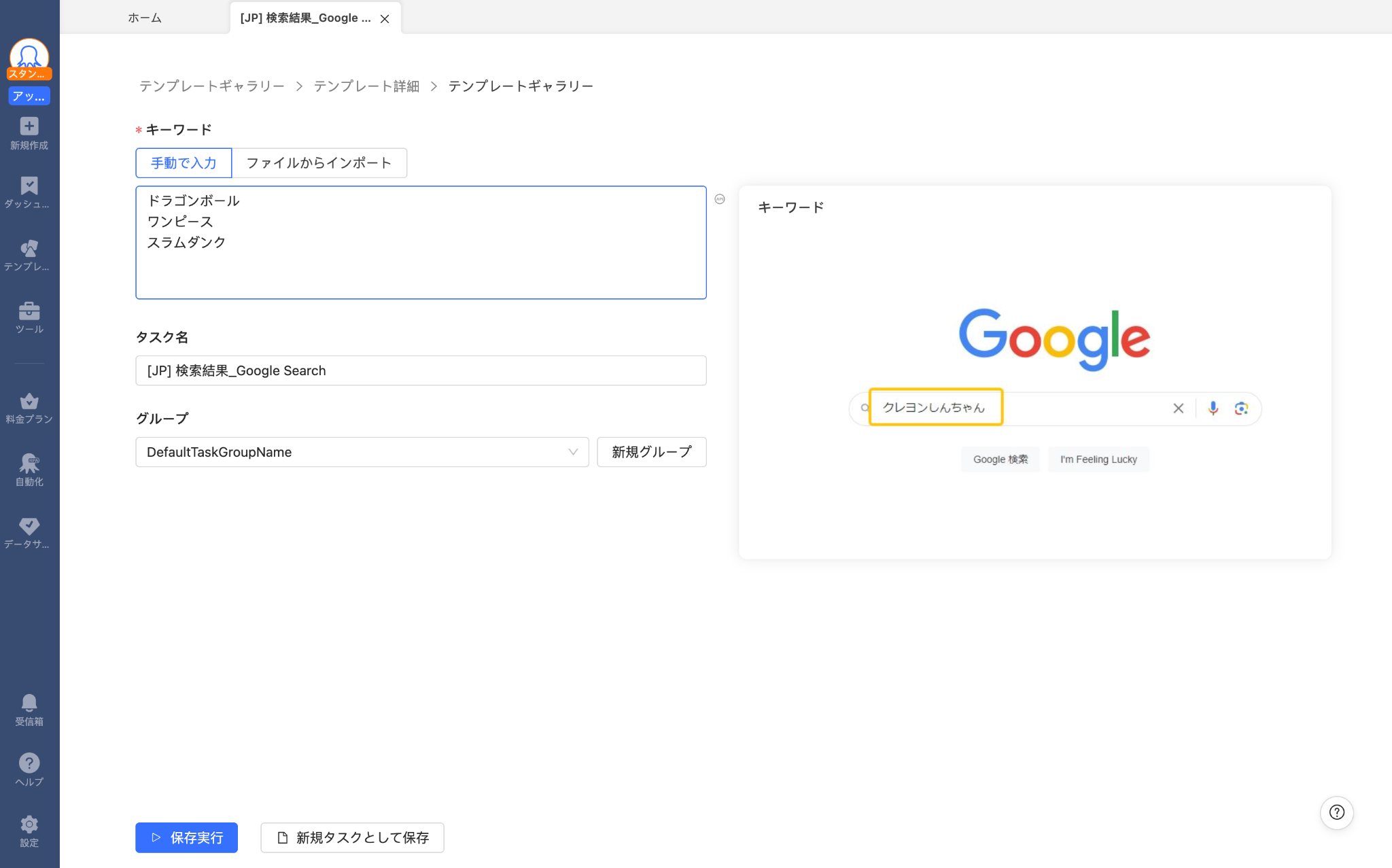

2.テンプレートの選択:Octoparseには多数のテンプレートが用意されており、特定のWebサイトやサービスに最適化されています。Google検索結果の取得には、Google検索に特化したテンプレートを選択します。

3.パラメータの設定:スクレイピングする情報の種類や範囲を指定します。例えば、特定のキーワードや地域に関する検索結果を指定することができます。

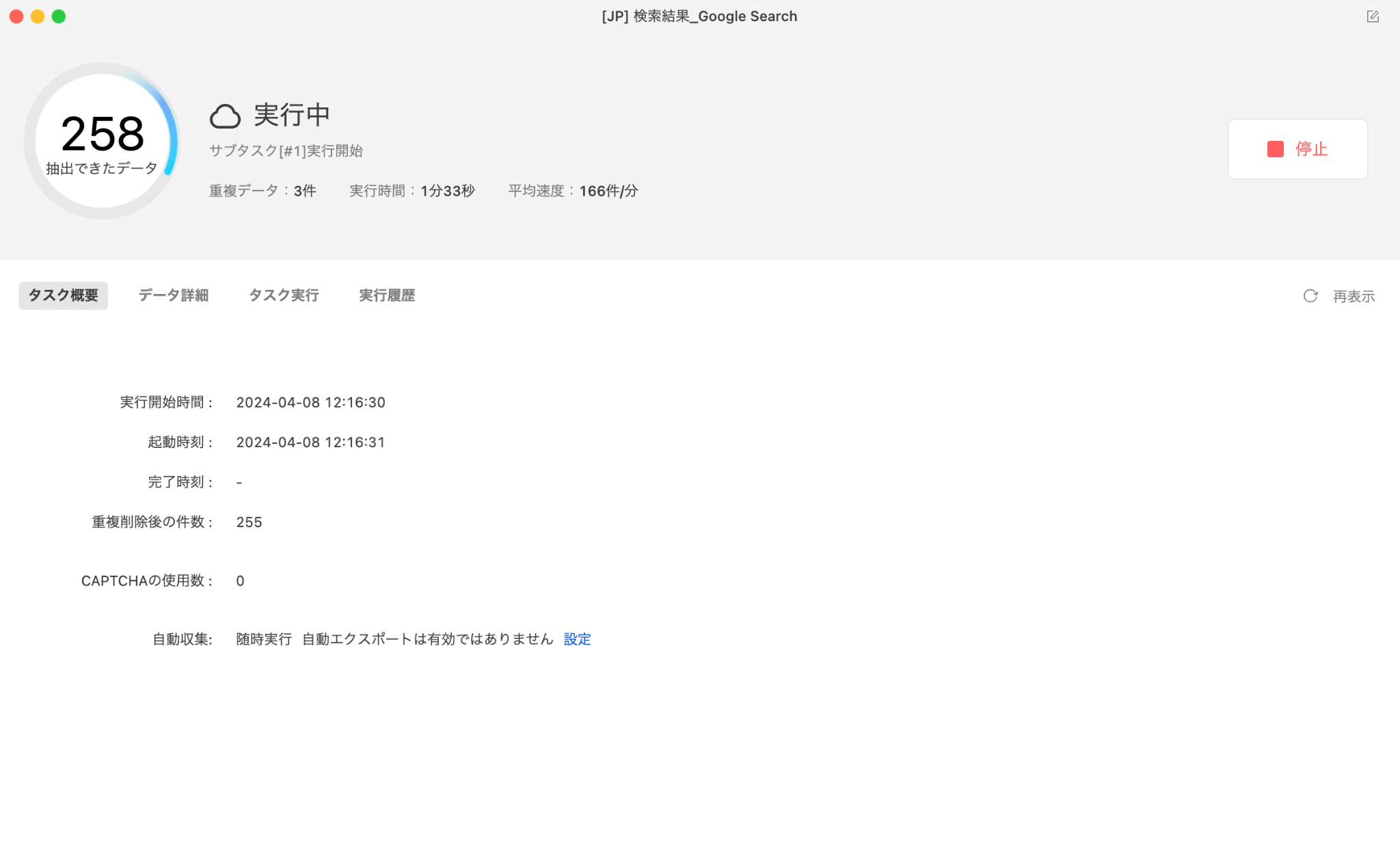

4.スクレイピングの実行:設定したパラメータに基づいてスクレイピングを開始します。Octoparseは自動的にWebサイトを巡回し、指定された情報を抽出します。

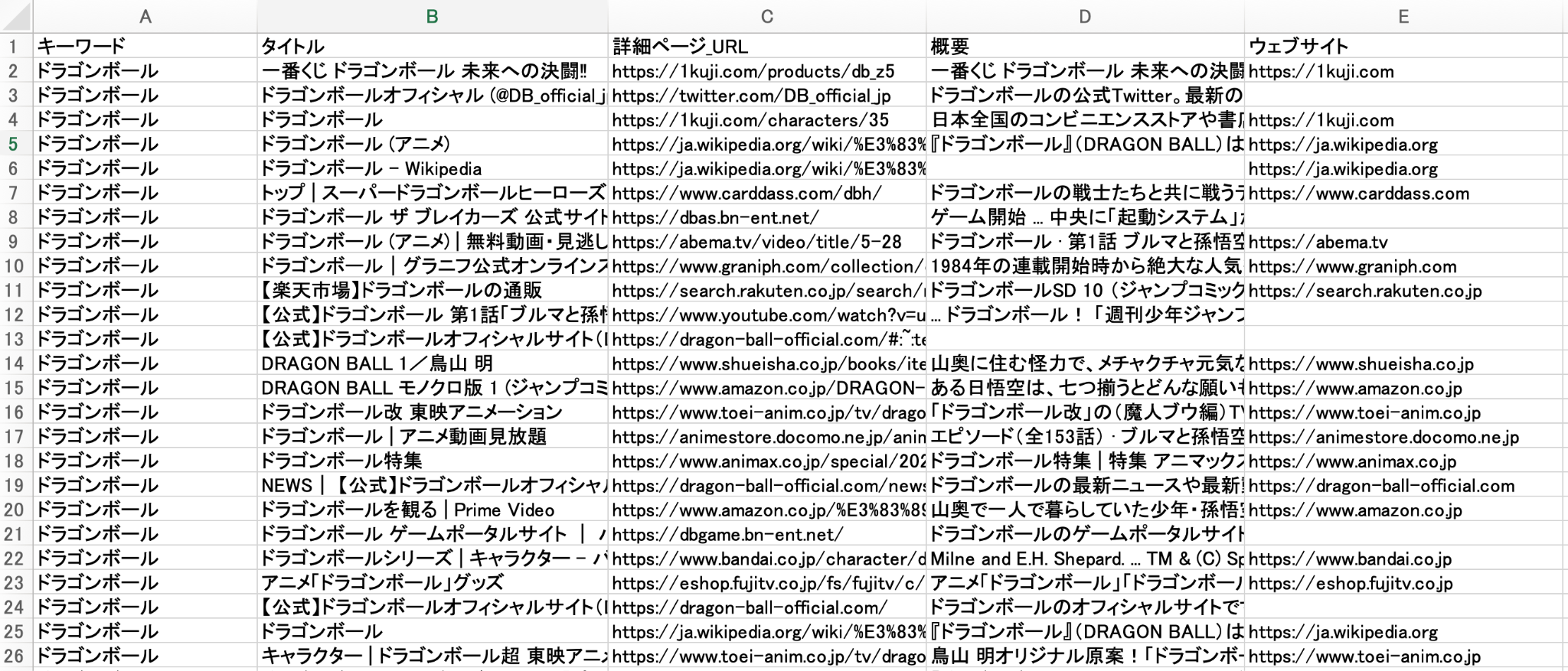

5.データのエクスポート:抽出したデータは、Excel、CSV、HTML、JSONなどの形式でエクスポートすることができます。これにより、データの後処理や分析が容易になります。

Octoparseを使用することで、Google検索結果からの情報収集を効率的に行うことができます。ただし、スクレイピングを行う際には、対象サイトの利用規約やロボット排除基準(robots.txt)を遵守することが重要です。

まとめ

Pythonでスクレイピングは、非エンジニアにとって簡単ではありません。特に、営業やマーケティング担当者、経営者など、プログラミングを学ぶ時間がなく、効率的にスクレイピングがしたい方はスクレイピングツールの利用がおすすめです。

競合サイト・EC・地図・SNS の情報を、Excel・CSV・Google Sheets にそのまま出力。

クリック操作だけで、価格・レビュー・店舗情報など必要な項目を自動抽出。

Google Maps・食べログ・Amazon・メルカリ向けテンプレートで、すぐに取得開始。

大量取得や定期実行でも止まりにくく、競合監視を継続できます。

毎日・毎週のデータ取得をクラウドで自動実行し、更新を見逃しません。

世界 600 万人以上が利用し、主要レビューサイトで高評価を獲得。