Webクローリング、またはWebデータ抽出とも呼ばれるWebスクレイピングは、単にWebサイトからデータを収集してローカルデータベースまたはスプレッドシートに保存するプロセスです。Webスクレイピングを初心者が聞いたら、遠ざけていく専門用語だと思われるかもしれないですが、実は思っている以上、簡単にできるものです。スクレイピングは、ニュースメディアや求人情報だけでなく、マーケティング、金融やEコマース、および数多くの他業界でも役割を果たしています。

Webスクレイピングと言えば、多くの人は「プログラミング」を思い浮かべるのではないでしょうか。確かに、Webスクレイピングツールというものが出る前に、PythonやRubyなどのプログラミングスキルが必要です。今では誰でも簡単にスクレイピングできる時代ですね。

Webスクレイピングツールはさまざまありますが、どれが一番なのかという疑問がある人もたくさんいるでしょう。ネットにあるほとんどのスクレイピングツールは極めて通用され、主に一般的で簡単なタスクを実行するように設計されているのです。つまり、期待しているほどカスタマイズ性や通用性に富んだものではないかもしれません。ご参考のために、この記事では人気のWebスクレイピングツールを10選まとめて、それぞれの特徴を紹介したいと思います。

1. Octoparse

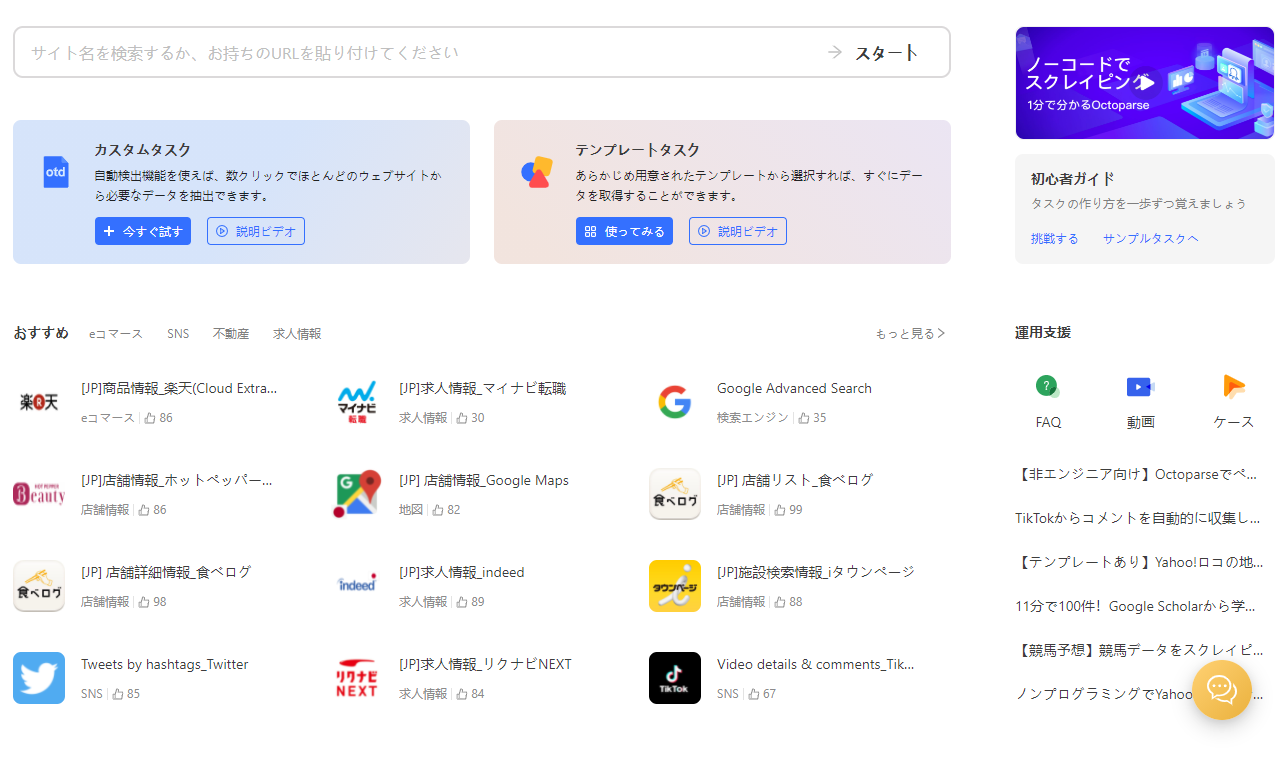

OctoparseはWebサイトからデータを抽出するために使用される、豊富な機能を備えた強力なWebスクレイピングツールです。コーディングせず、簡単なポイントアンドクリック操作をして、Webサイトからすべてのデータを収集ことが可能です。Webページ自動認識の機能を備え、取得先のURLを入力すると、データが自動的に検出され、ほぼハンズフリーでデータを抽出できます。取得したデータはExcel、HTML、CSVのような構造化フォーマットで、また画像、音声、動画、ドキュメントのダウンロードが可能です。

その他、より精度の高いデータ抽出のために、正規表現ツール、Xpathツールなどなど多くの便利なツールを搭載しています。さらにOctoparseはCaptchaバイパス、IPプロキシ設定、クラウド抽出の機能もあり、IPの自動ローテーションができるように仕組まれていて、IPアクセス拒否に悩まされることはもうありません。

最後、さまざまなのWebサイトからデータを抽出するために、Octoparseはすぐに使えるWebスクレイピングテンプレートを提供しています。具体的には、Octoparseのソフトには数十種類のあらかじめ作成されたテンプレート(Google Maps、Amazon、Twitter(The X)やIndeedなど)があり、パラメータ(ターゲットWebサイトのURL、検索キーワードなど)を入力するだけで、データが抽出されてきます。

メリット:

スクレイピングツールではCAPTCHAブロックにかかり予想通りのデータ取得が出来ませんでしたが、OctparseのIPローテーションは、CAPTCHAの発生頻度を減らすことができます。Captchaがトリガーされた場合、その問題を解決するためのCaptcha by Passサービスも備えています。

他のツールより、Octoparse無料版は取得ページ数の制限なしで最も強力な機能を提供しています。スクレイピングテンプレートでは、パラメータ(ターゲットページURL、検索用のキーワードなど)を入力し、データ収集を待つことだけです。海外の製品ですが、日本語サポートサービスも提供し、アプリのUIでも日本語化しているから、安心で使えます。

デメリット:

残念ながら、日本語サイトのチュートリアルは十分とは言えませんので、英語ができる方は、Octoparseの英語サイトでチュートリアルを参照することをお勧めします。

2.Import.Io

Import.Ioは、Webページ内の半構造化情報から構造化データへの変換に役たつWebスクレイピングプラットフォームです。これはビジネス上の意思決定の推進からアプリケーションや他のプラットフォームとの統合まで、あらゆる用途に使用できます。ストレージとテクノロジはすべてクラウドシステムに基づき、Webブラウザ拡張機能を追加するだけでツールを使用できます。シンプルで直感的なポイント&クリックの操作スタイルは、ページとデータフィールドを簡単に選択することができます。JSON RESTベースおよびストリーミングAPIを介したリアルタイムのデータ検索、多くの一般的なプログラミング言語およびデータ操作ツールとの統合を提供します。

メリット:Import.ioは、ほぼすべてのシステムをサポートする最先端のテクノロジを使用して、何百万ものデータが取得できます。洗練されたインターフェース、シンプルなダッシュボード、スクリーンキャプチャ、そしてユーザーフレンドリーな操作ガイドビデオのおかげで、さらに使いやすくしてくれます。

デメリット:無料プランはもう利用できません。各サブページにも費用がかかるので、多数のサブページからデータを抽出していると、コストがすぐに高まる恐れがあります。それに、Webサイトの構造に大きく依存するから、すべてのWebサイトでは動作するわけではありません。

3.Scraper

Scraperはオンライン調査を促進、データをすばやくGoogleスプレッドシートにエクスポートすることができるわずかなデータ抽出機能を備えたChromeの拡張機能です。Scraperは初心者だけでなく、OAuthを使用してデータをクリップボードにコピー、またはスプレッドシートに保存できる専門家を対象としています。Scraperはブラウザで機能し、対象URLを定義できるXPathを自動生成できる無料のWebクローラーツールです。包括的なクロールサービスは提供されないかもしれませんが、初心者には面倒な設定に取り組む必要はありません。

その仕組みは次のとおりです。特定のデータポイント、価格やランキングなどを選択して、ブラウザのメニューから[Scrape Similar]をクリックすると、データをExcelかGoogle Docsにエクスポートまたはコピーできます。このプラグインは基本的なものですが、素早く簡単にページをスクレイピングするために作られたものです。

メリット:Chromeの拡張機能として、簡単なスクレイピング作業だとScraperがすぐにできることは魅力です。

デメリット:Scraperはただの基本的なクローラーですから、簡単なWebページのみに、限られた抽出機能が持つ単純なクローリングプロジェクトを提供できます。

4.Zyte

Zyteは、インターネットから構造化された情報を抽出するために、いくつかの便利なサービスを提供している開発者向けのWebスクレイピングプラットフォームです。ZyteにはScrapy Cloud、Portia、Crawlera、Splashという4つの主要なツールがあります。Scrapy CloudはScrapy(オープンソースのデータ抽出フレームワーク)Webクローラーのアクティビティを自動化・視覚化することができます。Portiaは機能が制限されていて、非プログラマー向けのWebスクレイピングツールです。Crawleraは、50カ国以上のIPアドレスを持ち、IP禁止問題の解決策です。SplashはZyteによって開発されたオープンソースのJavaScriptレンダリングサービスです。Splashブラウザを使うと、JSを使用しているWebページをより適切にスクレイピングすることができます。

メリット:Zyteは、オープンソースフレームワークScrapyや視覚データスクレイピングツールPortiaなど、さまざまな地域の人々に合わせて適切なWebサービスを提供する強力なWebスクレイピングプラットフォームです。

デメリット:Scrapyはプログラマーに向け、Portiaも複雑なWebサイトを扱う場合では数多くのアドオンを追加する必要があるので、簡単に利用できません。

5.80legs

80legsは、カスタマイズされた要件に基づいて構成できる強力で柔軟なデータスクレイピングツールです。それは膨大な量のデータの取得と共に、抽出されたデータを即時にダウンロードするオプションをサポートしています。 80legsは、高速に機動し、わずか数秒で必要なデータを取得する高性能のWebクローリングを提供します。開発者は、クローリングネットを広げるために80legs APIを自分のアプリケーションに組み込むことができます。

メリット:80legsは、専用線アクセスを許可し、顧客がクローリングした分だけを支払うようにすることで、Webスクレイピングテクノロジを小規模企業や個人にとってより利用しやすくします。

デメリット:80legsは前に述べたほかのツールほどの適応性がありません。大量のデータを取得したい場合は、カスタマイズ取得するデータ、作成済みのAPI、およびクロールアプリケーションのいずれかを選択する必要があります。

6. Parsehub

ParseHubはインタラクティブマップ、カレンダー、検索、フォーラム、ネスト化されたコメント、無限スクロール、認証、ドロップダウン、フォーム、Javascript、Ajaxなどを簡単に処理できる視覚的なデータ抽出ツールです。ParsehubのデスクトップクライアントはWindows、Mac OS X、Linuxなどをサポートしています。ブラウザ内に組み込まれているWebアプリケーションを使用することもできます。ParseHubは無料プランのほか、大量のデータ抽出ためのカスタマイズ法人プランも提供しています。

メリット:ParseHubはOctoparseのように、様々なニーズに適応してオンラインデータを収集できます。その利点といえば、ParsehubはAPIアクセス権限を持つプログラマーによりフレンドリーです。

デメリット:無料版がありますが、5つのプロジェクトと最大200ページまでの制限があります。 様々な機能が提供されていますが、そのほとんどが有料になります。

7. WebHarvy

WebHarvyは、軽くて視覚的なポイント&クリック式のWebスクレイピングツールです。各種類のWebサイトからテキスト、URL、および画像を抽出することが可能です。抽出されたデータは一般的なフォーマット(CSV、Txt、XML)とデータベース入力用のSQLに保存することができます。また、匿名でスクレイピングし、Webサーバーによるブロック防ぐためのプロキシサーバー/ VPNも提供します。

メリット:WebHarvyは使いやすく覚えやすく安定です。いくつかのエクスポートデータ形式に対応でき、すばやくWebスクレイピングすることに優れています。

デメリット:ドキュメントの抽出をサポートしていないほか、無料版も提供していません。

8. Sequentum Enterprise

Sequentum Enterpriseは、エンタープライズ(企業)向けのWebクローラーツールです。あらゆるWebサイトからコンテンツを抽出し、Excel、XML、CSVのほか、ほとんどのデータベースに構造化データとして保存できます。

豊富なスクリプト編集機能と優れたデバッグインターフェースを提供しているため、高度なプログラミングスキルを持つ人に向いています。ユーザーはC#またはVB.NETを使って、スクリプトをデバッグまたは書き込むことで、クローリングプロセスを制御することが可能です。

メリット:サードパーティのデータ分析・レポートアプリケーションとの統合が可能で、抽出したデータをExcel、XML、CSVにエクスポートすることができます。

デメリット:ツール開発用ということで、プログラミング経験のある方を向けます。

9. Dexi.io

Dexi.Ioは、開発、ホスティング、およびスケジューリングサービスを提供するクラウドベースのWebスクレイピングツールです。ポイント&クリックのUIを備え、コーディングする必要がありません。簡単なタスクを作成するために、Extractor、Crawler、およびPipes、3種類のロボットがあります。取得したデータはJSON / CSVデータとして利用可能であり、またReSTを通して外部アプリケーションからアクセスすることもできます。このWebスイートは、CAPTCHA解決、プロキシソケット、ドロップダウンを含むフォームへの記入、正規表現のサポートなど、最新のWebスクレイピング機能のほとんどを提供しています。また、取得したコードのJavaScript評価もサポートしています。

メリット:ブラウザベースであるため、Dexi.io CAPTCHA解決はより便利なことです。それに、多くの第三者サービス(キャプチャソルバー、クラウドストレージなど)をサポートするから、それらをボットに簡単に統合できます。

デメリット:商用サービスとしてもちろん、無料版を提供していません。また、フローを理解するにはかなり複雑で、デバッグする場合もあるので面倒だと感じます。

いかがでしょうか?あなたのニーズに合わせて最適なスクレイピングツールを見つけましょう!