Octoparse ブログ

Webスクレイピング、データ抽出、データ分析、Webスクレイピングツール、ビッグデータなどに関する記事を掲載しています。

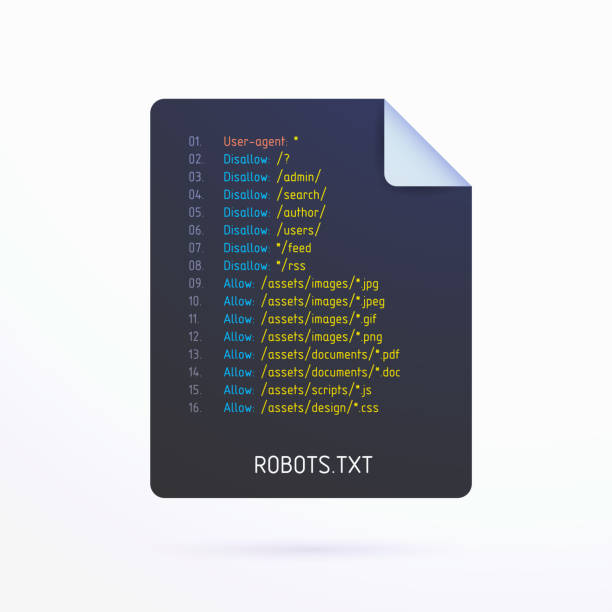

【スクレイピング対策】robots.txtの確認方法を解説

robots.txtの基本的な仕組みから具体的な確認方法、記述ルール、さらにSEOやスクレイピングに役立つポイントまでを詳しく解説します。

2025-05-06T12:16:37+00:00 · 7 min read

【Python】SeleniumでWebスクレイピングする方法

Seleniumの基本機能や活用方法について解説します。また、実際にコピペだけでWebスクレイピングができるサンプルコードも紹介していますので、ぜひ最後までご覧ください。

2025-05-06T11:33:35+00:00 · 6 min read

【図解】XPathとは?基本概念から書き方までわかりやすく解説!

XPathの基本的な仕組みから具体的な書き方、よく使われる関数や実践的なユースケースまでを詳しく解説します。スクレイピングや業務効率化を目指す方はもちろん、初めてXPathに触れる方にも役立つ内容となっていますので、ぜひ最後までご覧ください。

2025-05-06T11:06:40+00:00 · 8 min read

情報収集とは?情報収集の目的・方法・やり方・ツールの徹底解説

情報収集とは何かを改めて整理した上で、その目的や実践方法、スキル向上のコツ、おすすめのツールまで詳しく解説します。

2025-04-21T12:05:40+00:00 · 7 min read

インターネットで情報収集する方法6選!収集時のポイントやまとめ方も解説

効率的に情報を収集する方法をご紹介します。また、情報収集時に気をつけたいポイントや、得た情報を効率的にまとめる方法もお伝えしますので、ぜひ参考にしてください。

2025-04-21T11:44:19+00:00 · 5 min read

APIとは?基本知識から活用法、メリット・デメリットまで徹底解説

APIとは何か、その種類や仕組み、利用のメリットとデメリット、具体的な活用事例、そして利用時の注意点を詳しく解説します。

2025-04-21T10:43:09+00:00 · 6 min read

Webスクレイピングに最適なプログラミング言語7選を徹底比較!

Webスクレイピングにおすすめのプログラミング言語を紹介します。これからWebスクレイピングを独学しようと考えている方は、ぜひ参考にしてください。

2025-04-17T16:43:36+00:00 · 6 min read

【必読書&便利サイト】AI(人工知能)学習の王道ガイド2025年版!初心者から上級者まで12冊!

AIの理解を深めるためのおすすめ書籍12冊を紹介します。AI学習を効率的に進めるための教材選びにお役立てください。

2025-04-17T16:30:23+00:00 · 7 min read

IP制限とは?仕組みやメリット・デメリット、注意点まで解説

IP制限の基本から、導入するメリット・デメリット、注意点までわかりやすく解説します。「難しそうだから」と避けていた方でも、読めば「なるほど、そういうことか」と理解できる内容になっていますので、ぜひ最後までご覧ください。

2025-04-14T11:28:51+00:00 · 6 min read

Webスクレイピングは違法?合法的なやり方と禁止サイトの確認方法を解説

Webスクレイピングが違法か合法かについての基本的な理解を深め、合法的に行うための方法や、禁止されているサイトをどのように確認するかについて解説します。

2025-04-14T10:45:15+00:00 · 6 min read

正規表現自動作成・生成ツールの紹介とよく使う正規表現のまとめ【コピペだけすぐ使える!】

正規表現の基本構文、具体的な使用例、さらに自動生成ツールの活用方法について解説します。処理の自動化や作業効率化のため、実務に役立つ正規表現の使い方を身につけましょう。

2025-04-14T10:20:34+00:00 · 6 min read

【スクレイピング対策】バレないようにする方法を解説

スクレイピングをバレないようにするための5つの対策を解説します。また、Webスクレイピングの利用に不安を感じる方は以下の記事もあわせてご参照ください。

2025-04-08T11:51:17+00:00 · 6 min read