インターネット上には膨大なデータが存在します。それらのデータを効率的に収集したり、分析したりすることはビジネスの成長に直結するといっても過言ではありません。特に、マーケティング、新規商品開発、新規事業開発などの分野では、Webサイトから必要な情報を素早く取得し、分析することで市場内の競争で優位性を保つことが可能です。

そうしたデータ収集を効率化させることで注目されているのが「Webクローラーツール」です。近年では専門家以外でも手軽に利用できるWebクローラーツールやサービスが多数登場しています。

本記事では、おすすめのWebクローラーツール・サービス9選をご紹介します。自社のビジネスに最適なツールを見つけ、データ収集の効率化を図りましょう。

Webクローラーとは

Webクローラーとは、インターネット上のWebページを自動的に巡回し、情報を収集するプログラムのことです。一般的に、WebクローラーはWebサイトをインデックス(検索エンジンのデータベースに登録すること)するために使用されますが、企業の市場調査や競合分析、データ収集にも活用されています。

Webクローラーの仕組みは、ページ内のリンクをたどることで次々と新しいページを発見し、指定された条件に基づいてデータを取得していきます。この一連のプロセスを「クローリング」と呼びます。クローリングによって収集した情報を整理したり分析したりすることで、有益なデータとして活用できます。

<クローラーの主な用途>

- SEO対策のためのWebページをインデックスさせる

- 企業が特定の市場データを収集し、分析に役立てる

- 価格比較サイトがリアルタイムで商品情報を取得する

Webクローラーの種類

Webクローラーには、用途や目的に応じた4つの基本タイプがあります。

1. 集中型Webクローラー

特定のトピックに関するWebコンテンツのみを検索・収集するクローラーです。一般的なクローラーがページ内のすべてのリンクをたどるのに対し、集中型クローラーは関連性の高いリンクのみを監視し、効率的に情報を取得します。主にニュースサイトや専門情報の収集などに利用されます。

2. インクリメンタルクローラー

すでに取得したデータの更新を目的とするクローラーです。定期的にWebサイトを再訪問し、変更されたページのみをインデックスすることで、データの鮮度を保ちます。検索エンジンやニュースメディアの更新管理に活用されます。

3. パラレルクローラー

複数のクローリングプロセスを同時に実行し、ダウンロード速度を最大化するクローラーです。大量のデータを素早く収集する必要がある場合に使用され、特にビッグデータ分析やマーケティングリサーチなどで活用されています。

4. 分散型クローラー

複数のクローラーを同時に稼働させることで、複数のサイトを並行してインデックス登録するクローラーです。クラウドベースのシステムと組み合わせることで、よりスケーラブルなデータ収集が可能になります。主に、検索エンジンや大規模データ分析に向いています。

Webクローラーの仕組みと特性

Webクローラーにはさまざまな仕組みや特性があり、効率的なデータ取得のためには、特性を理解したうえで最適な設定が求められます。特に、クロールの頻度、画像や動画の取得、アクセス制御の仕組みは重要なポイントです。

クロール頻度と設定

Webクローラーは、一定の間隔でWebサイトを巡回し、最新の情報を取得します。クロールの頻度を適切に設定しないと、サーバーに負荷をかけたり、アクセス制限を受ける可能性があります。

更新頻度が高いサイトではクロール間隔を短くし、変化の少ないサイトではクロール回数を抑えることで、効率的なデータ収集が可能になります。

画像・動画の取得機能

Webクローラーは、テキストデータだけでなく、画像や動画の取得も可能です。しかし、画像や動画はデータ量が大きく、保存や処理の負荷が高いため、必要な情報のみを取得する工夫が求められます。

また、サイトによっては画像や動画の取得を制限している場合があるため、取得方法の選択も重要です。

アクセス制御(robots.txtなど)

多くのWebサイトでは、robots.txtを使用してクローラーのアクセスを制御しています。このファイルには、特定のページのクロールを禁止するルールが記載されており、クローラーはこれを遵守する必要があります。

また、ログイン認証やCAPTCHAを導入しているサイトもあり、これらの制限を考慮した運用が求められます。

Webクローラーツールとは?

Webクローラーツールとは、インターネット上の情報を効率的に収集し、データ分析や業務改善に活用するためのソフトウェアです。具体的には、検索エンジンのインデックス作成、競合分析、価格調査、マーケットリサーチ、SEO対策、データマイニングなど、幅広い用途で利用されています。

またツールによって機能や特性が異なるため、ツールを選ぶ際はデータの取得量やカスタマイズの必要性、運用コストなどを考慮することが重要です。

ここでは、Webクローラーツールの特徴や選び方について詳しく解説します。

Webクローラーツールの特徴

Webクローラーツールにはさまざまな種類があり、それぞれの特徴に応じて適した用途が異なります。

クラウドベース

クラウド型のWebクローラーサービスは、自社で専用のサーバーを用意する必要がなく、オンラインでデータ収集を実行できるのが特徴です。これにより、ローカル環境に負荷をかけずに、大規模なデータ取得をスムーズに行うことができます。

また、クラウドベースのサービスは拡張性が高く、必要に応じて機能や処理能力を柔軟に増やせる点もメリットです。

導入が容易

Webクローラーサービスは、ソフトウェアのインストールやセットアップが不要で、アカウント登録やAPIの設定だけで利用できるものが多いのが特徴です。特に、プログラミング知識がなくても利用できるノーコードツールが増えており、エンジニア以外の営業職やマーケティング担当者でも簡単に活用できます。

カスタマイズ性が高い

一部のWebクローラーツールは、ユーザーが独自のクローリングルールを設定できる高いカスタマイズ性を持っています。PythonやJavaScriptなどのプログラミング言語と組み合わせて、特定のデータのみを抽出したり、処理を自動化したりすることが可能です。

特にオープンソースツールでは、APIを活用して他のシステムと連携させたり、クローリングの頻度や条件を細かく調整したりできます。

Webクローラーツールの選び方

用途に応じて最適なツールを選ぶことで、効率的にデータを収集し、ビジネスの意思決定に活かすことができます。

Webクローラーツールを選ぶ際には、以下のポイントを考慮すると良いでしょう。

| 選定ポイント | 確認事項 |

| データの取得対象と対応範囲 | 収集したいデータの種類(テキスト、画像、動画など)に対応しているかJavaScriptを使用した動的なページのクローリングが可能か |

| 操作の簡便さ | ノーコードで設定できるかAPI連携が可能か |

| スケーラビリティとパフォーマンス | 大量のデータを短時間で収集できるかリアルタイムでのデータ取得が可能か |

| コストと料金プラン | 無料プランやトライアルがあるかデータ取得量や処理回数に応じた柔軟な料金プランが用意されているか |

Webクローラーツール・サービスおすすめ9選

Octoparse

Octoparseは、Webサイトからデータを抽出できる強力なWebクローラーツールで、WindowsとMacに対応しています。海外の製品ですが、操作画面やチュートリアルはすべて日本語に対応しています。Octoparseは内蔵ブラウザを備えており、マウスクリックで簡単にデータを抽出できます。

さらに、誰でもかんたんにサービスを使いやすくするためのWebクローラーテンプレートを豊富に用意しています。例えば、Yahooショッピング、楽天市場、マイナビ転職、X (旧 Twitter)、食べログなど、利用者が多い人気サイトを中心としたテンプレートが充実しており、テンプレートを選択し、パラメータを入力するだけで、あとは自動的にデータが抽出されていきます。取得したデータをCSV、Excel、またはデータベースなどの構造化フォーマットとして保存や編集が可能です。

加えてOctoparseはクローリングのスケジュール設定が可能です。決められたタイミングに設定すれば、後は何もしなくても常に最新情報にアクセスできます。その他、セキュリティ管理やサーバー管理などのハードウェア保守も不要です。

<特徴・機能>

- IPアドレス自動巡回機能で、Webサイト側のアクセス拒否を効果的に避けられる

- プログラミングスキルを必要せず、直感的なマウス操作のみで設定が可能

- 人気サイトのテンプレートが豊富なので目的に合わせてかんたんに扱える

- フリーミアムなので無料プランから利用可能

Screaming Frog SEO Spider

Screaming Frog SEO Spiderは、SEO向けのWebクローラーツールで、サイトの技術的な分析や問題点の特定を目的としています。Windows、Mac、Linuxに対応しており、SEO専門家やマーケティング担当者に広く利用されています。無料版では500 URLまでクロール可能で、有料版では無制限のクロールや高度な分析機能を利用できます。

<特徴・機能>

- サイト構造の可視化:内部リンクやサイトマップを分析し、SEO最適化をサポート

- リンクエラーチェック:404エラーやリダイレクトの問題を即座に検出

- メタデータ分析:ページタイトルやメタディスクリプションの最適化を支援

- JavaScript対応:JavaScriptレンダリングに対応し、動的サイトのクロールも可能

- Googleツールとの連携:Google AnalyticsやSearch Consoleと統合し、SEOデータの収集を強化

Semrush

引用:SEMRUSH

Semrushは、デジタルマーケティングの全領域をカバーする包括的なツールです。SEO、コンテンツマーケティング、競合分析、PPC、ソーシャルメディア戦略など、オンラインでのビジネス成長を加速するための多機能を提供します。ユーザーは、市場の動向を把握し、競合他社の戦略を分析し、自社のオンラインプレゼンスを最適化するための洞察を得ることができます。

<特徴・機能>

- 包括的なキーワード分析:多数の国内外キーワードを発見・分析し、効果的なSEO戦略の立案が可能

- 詳細なバックリンク分析:ドメイン別のバックリンクプロファイルを分析し、サイトの信頼性向上に貢献

- 競合他社の戦略分析:競合他社のマーケティング戦略を包括的に分析し、自社のマーケティング戦略を強化

Web Scraper

Web ScraperはGoogle拡張機能で、無料で利用できます。データ集計や画像一括取得など、かんたんな操作だけでWeb上のあらゆるデータを、Excelやスプレッドシートに保存でき、データ収集の手間を大きく削減します。

Web Scraperはデータ抽出機能が限られていますが、Webクローリングの知識がない初心者にとってはシンプルで使いやすく、クローリングを体験する分には十分重宝するでしょう。

<特徴・機能>

- 抽出データは、Excel、CSV、MS Access、MySQL、MSSQL、XML、JSONにエクスポート可能

- Chromeブラウザ上のわずかな操作だけで、無料でスクレイピングを実行可能

- 製品価格調査、レビュー調査、営業リストの作成などあらゆるビジネスシーンで利用可能

TOWA

引用:TOWA

TOWAは、企業向けのWebクローリング・スクレイピングサービスで、競合分析、市場調査、ECサイトの価格監視などに活用されています。クラウドベースで提供されており、大量のデータ収集を効率的に行うことが可能です。

<特徴・機能>

- ノーコードで利用可能:プログラミング不要で簡単にデータ取得が可能

- クラウドベース:専用サーバー不要で、大規模なデータ収集に対応

- カスタマイズ性:特定のデータフォーマットでの出力やフィルタリング機能が充実

- 定期的なデータ更新:スケジュール設定により、自動で最新データを取得

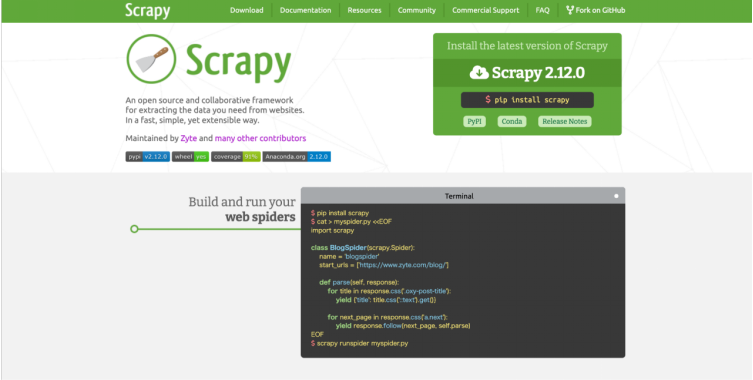

Scrapy

引用:Scrapy

Scrapyは、Pythonで開発されたオープンソースのWebクローリングフレームワークで、開発者向けに特化しています。データスクレイピングや情報収集を効率的に行うことができ、拡張性が高い点が特徴です。

<特徴・機能>

- 高速なデータ収集:並列処理を活用し、効率的なクロールが可能

- 柔軟なカスタマイズ:Pythonで記述でき、データ抽出ルールの設定が自由自在

- クラウド展開:Zyte Scrapy Cloudと連携し、大規模なデータ収集を容易に実行

- 豊富なコミュニティサポート:オープンソースのため、多くの開発者による情報共有が活発

Lumar

Lumar(旧Deepcrawl)は、ウェブサイトの技術的健全性をワンプラットフォームで管理するツールです。デジタルマーケティング、SEO、ウェブサイト駆動のビジネス成長機会の創出において、実行可能で効果の高いインサイトを提供します。業界で最速のスピードを誇るクローラーを使用し、テクニカルSEO関連の指標やインサイトを迅速に提供することで、サイトの最適化と掲載ランキングの向上を実現します。

<特徴・機能>

- 業界最速のサイトクローラー: 秒速450URLのスピードでサイトをクロールし、迅速なデータ収集を実現

- 組み込みレポートとカスタム抽出: 数百のレポートとカスタム抽出機能を使用して、詳細なSEO分析が可能

- 技術的SEOの最適化: サイトの技術的パフォーマンスをモニタリングし、オーガニックの拡大を通じた収益拡大のチャンスを創出

Pigdata(スクレイピング代行サービス)

引用:PigData

Pigdataが提供するスクレイピング代行サービスは、競合調査、市場分析、DX推進のためのデータ収集に特化しています。単なるデータ取得にとどまらず、データサイエンティストによる分析支援や法的リスクの管理も行い、安全で効果的なデータ活用をサポートします。

特に、WebサイトやSNS、ECサイト、PDFファイルなど、多様なデータソースからの取得が可能で、クライアントのニーズに応じた柔軟な対応を強みとしています。

<特徴・機能>

- 幅広いデータ収集に対応:テキスト、画像、PDFなど、多様なフォーマットのデータを取得可能

- カスタムデータ解析:業界特化型のレポート作成やインサイト提供が可能

- 法的リスクの管理:IT弁護士監修のもと、適切なスクレイピング手法を採用

- 継続的なデータ提供:定期的なデータ更新やダッシュボード形式での提供が可能

ShtockData

引用:ShtockData

ShtockDataは、日本国内で提供されているWebスクレイピング・クローリングサービスで、市場調査や企業情報の取得に特化しています。ノーコードでの利用が可能で、データ抽出を自動化できます。

<特徴・機能>

- セルフサービス型と代行サービスの両方を提供:自社でスクレイピングを行うことも、完全に外部委託することも可能

- 簡単なデータ設定:管理画面から対象サイトと取得範囲を指定するだけでデータ収集を開始

- 大規模データ対応:大量のWebデータを定期的に取得し、業務のDX化を支援

- 初期費用0円で導入可能:手軽に始められる料金体系

Webクローラーツール導入時の注意点

Webクローラーツールを導入する際には、単にデータを取得するだけでなく、適切な運用や管理が求められます。無計画にクローリングを行うと、サーバーへの負荷やアクセス制限、法的リスクなどの問題が発生する可能性があります。また、取得したデータの活用方法や保存管理にも注意が必要です。

ここでは、Webクローラーツールを導入する際に注意すべきポイントを技術面・法的リスク・運用管理の観点から解説します。

サーバー負荷とアクセス制限の回避

Webクローラーは短時間で大量のリクエストを送るため、対象サイトのサーバーに負荷をかける可能性があります。負荷が大きすぎると、クローラーのアクセスをブロックされたり、IPアドレスを制限されたりすることがあります。

これを防ぐためには、クロール頻度を適切に設定し、必要以上のアクセスを控えることが重要です。また、対象サイトのrobots.txtのルールを確認し、禁止されているページにはアクセスしないようにしましょう。

法的リスクとデータ利用の注意点

Webクローリングで取得したデータは、著作権や利用規約の対象となる場合があります。特に、個人情報を含むデータや商用利用が制限されているコンテンツを無断で取得することは、法的問題につながる可能性があるため、事前に利用規約を確認することが重要です。

また、一部のWebサイトではAPIを提供しており、クローリングではなく公式APIを利用することで、より安全かつ効率的にデータを取得できる場合があります。APIの活用も検討するとよいでしょう。

データの保存と管理

Webクローラーツールを使用して取得したデータは、適切に保存・管理することが求められます。特に、大量のデータを扱う場合は、ストレージの確保やデータの整理方法を考慮する必要があります。

また、定期的に更新されるデータを取得する場合、古いデータとの比較や重複排除の処理も重要になります。データの保存形式(CSV、JSON、データベースなど)や、データクレンジングの方法を事前に計画しておくことで、スムーズに活用できます。

まとめ

Webクローラーを活用することで、競合分析、市場調査、SEO対策など、さまざまな分野でのデータ収集を効率化することが可能です。本記事でご紹介したとおり、Webクローラーツール・サービスにはさまざまな種類が存在するため、目的や用途にあったものを導入してください。

また、導入時には、サーバー負荷への配慮、法的リスクの確認、データ管理の徹底といったポイントにも注意しながら運用しましょう。

競合サイト・EC・地図・SNS の情報を、Excel・CSV・Google Sheets にそのまま出力。

クリック操作だけで、価格・レビュー・店舗情報など必要な項目を自動抽出。

Google Maps・食べログ・Amazon・メルカリ向けテンプレートで、すぐに取得開始。

大量取得や定期実行でも止まりにくく、競合監視を継続できます。

毎日・毎週のデータ取得をクラウドで自動実行し、更新を見逃しません。

世界 600 万人以上が利用し、主要レビューサイトで高評価を獲得。